chenxuan note

Chenxuan

How to contact me

- chenxuanweb@qq.com,this is my email

- chaiquan@androidftp.top will also work

Official website

- resume.chenxuanweb.top (this is my resume)

- www.chenxuanweb.top

- blog.chenxuanweb.top

- my github

- my gitee

Tips

- Since I am a newbie, please contact me(by email chenxuanweb@qq.com or chaiquan@androidftp.top) if there is any error

- It's not a place where everything is documented in great detail, it's just places I'm not familiar with. If you want to learn systematically, this is not a good choice.

- Obsidian Chinese Help

- thank you for coming! have a good time

burn the emacs heresy,Vim is immortal.(doge)

Update Time

- last update in 2026年 01月 27日 星期二 23:16:41 CST

Thank

- Power by mdbook

- Create by Obsidian2web

go mod镜像加速

go env -w GO111MODULE=on

go env -w GOPROXY=https://goproxy.cn,direct

清除缓存

- 清除所有的包缓存

go clean --modcache

- 清除特定版本的包缓存(暂时没发现)

目录结构

目录为go/pkg/mod

├── cache

├── dubbo.apache.org

├── github.com

├── gitlab.dian.org.cn

├── git.sublive.app

├── go.etcd.io

├── golang.org

├── google.golang.org

├── gopkg.in

├── gorm.io

├── go.uber.org

└── vimagination.zapto.org

cache记录压缩包和校验文件等内容

不同的网站拥有不同的文件夹存放

包与路径

- import的是包的路径,不是包名,会根据import的值去寻找这个路径下的包

- import之后会去路径下找包,找到文件中第一行声明的package才是真正的包名

- 路径下的包名可以和目录不一样(最好一样),但是同一个路径只能有一个包名

私有仓库包获取

- go env -w GOPRIVATE="*.gitlab.cn" 设置为私有仓库

- go env -w GONOPROXY="*.gitlab.cn" 设置不走代理

- 编辑

~/.netrc文件(这个文件是纯文本文件不能使用任何的环境变量)

machine git.gitlab.cn login chenxuan password 123456789

- 第三步也可以更改为编辑

~/.gitconfig文件

[url "ssh://git@github.com/"]

insteadOf = https://github.com/

git config --global http.sslverify false解除git ssl验证

某个pkg最新版本

- 更改go.mod中的包版本为v0.0.0

gitlab不支持ssh拉取多级私有包

问题原因

- go get分两个过程,可以使用

go get -v查看记录- 获取链接的源信息,即meta data,此时使用的是https协议

- 下载代码,此时使用的是ssh(当然这里也可以更改为http)

- 超过2的sub目录在 未认证的情况下因为可能是仓库的信息(也可能是sub目录,一级不可能是仓库),这里涉及仓库信息,因此https没带这token禁止获取

- 使得go get命令无法获取超过1 的仓库的meta data,无法clone

解决办法

netrc

- 方法参考Go包管理 > 私有仓库包获取

- 核心是走https,meta请求就携带pwd,可以获取

- 优点:简单方便

- 缺点:cicd根本用不了,会信息泄漏

replace

- 核心参考参考

require (

private.gitlab.instance/project/team/somename v1.0.0

)

replace (

private.gitlab.instance/project/team/somename => private.gitlab.instance/project/team/somename.git v1.0.0

)

- 添加.git后缀,这个办法也可以改进为直接包名带着.git

- 优点:能解决问题,而且没有信息泄漏问题,简单方便

- 缺点:丑陋,莫名其妙带上.git

相关讨论连接

- https://github.com/golang/go/issues/34094#issuecomment-556898897

- https://gitlab.com/gitlab-org/gitlab/-/issues/36354

go多级包管理

go mod init github.com/{帐号}/{仓库名字}/{子包的名字},目录demo

.

├── README.md

├── a

│ ├── a.go

│ └── go.mod

└── b

├── b.go

└── go.mod

- 需要注意的是,这时候的tag规则是

{子包的相对路径}/v1.0.0

git tag

a/v1.0.0

b/v1.0.0

b/v1.0.1

- import的时候是tag需要注意

import (

github.com/robberphex/go-test-multi-module/a v1.0.0

)

- 参考:https://learnku.com/articles/58947 和 https://tonybai.com/2023/05/10/a-guide-of-managing-multiple-go-modules-in-mono-repo/

引用特定分支

- 直接使用

go get命令 类似go get github.com/golang/go@master - 直接在go.mod文件中添加,格式: git地址 v0.0.0-时间戳- commint id 例如: github.com/golang/go v0.0.0-20221013081251-69aaa89ae530

依赖地狱

- 项目引用了 A包和B包, A和B都引用了C包, 但是A用的是v1.0,B用的是v2.0, C包的v2.0不兼容 v1.0 , 导致崩溃无法编译

- go mod的解决办法是通过package路径加上version使得两个包依赖的完全是不同的的包, 使得同一个程序可以存在两个相同名字版本不同的包(本质依赖了包本身是隔离的,不会引起冲突的问题)

- 第一个代价就是构建出来的app的二进制文件size变大了,因为二进制文件中包含了多个版本的P3的代码;第二个代价,可能也算不上代价,更多是要注意的是不同版本的module之间的类型、变量、标识符不能混用

- 需要注意的是: 这种的多版本共存的情况只存在于, 两个package version的 major 版本发生了不同, 如果是同一个major, 那么会使用最大的版本号(可能出现不兼容问题)

- 冲突时候只要 major 相同, 默认使用最新的, 但是如果包管理方有问题就很容易

[!tip] 参考 为什么有了Go module后“依赖地狱”问题依然存在 | Tony Bai

查找包依赖来源

go mod why -m gopkg.in/yaml.v2展示的链路就是引用包的来源

更新go 版本在gomod

- 使用

go get go@1.22.12如果无法满足的包会自动删除, 这样就知道是哪个包的问题了

中间件的使用

- group 里面use的中间件只能在注册的路由生效,否则会报错

- default 里面use无论任何请求都会生效

Go json

- 处理[]byte时候会自动进行base64编码,bind会自动解码

- []byte字段json解码时只能接受base64串

go test

初始化

- go test 会主动调用初始化

- 如果需要其他初始化需要使用TestMain()

覆盖率

go test -v -covermode=set -coverprofile=hint_test.out

压力测试

go test -bench .

语言知识点

- make函数如何不指定大小,默认都是0,包括chan,因此初始化map一定要指定大小

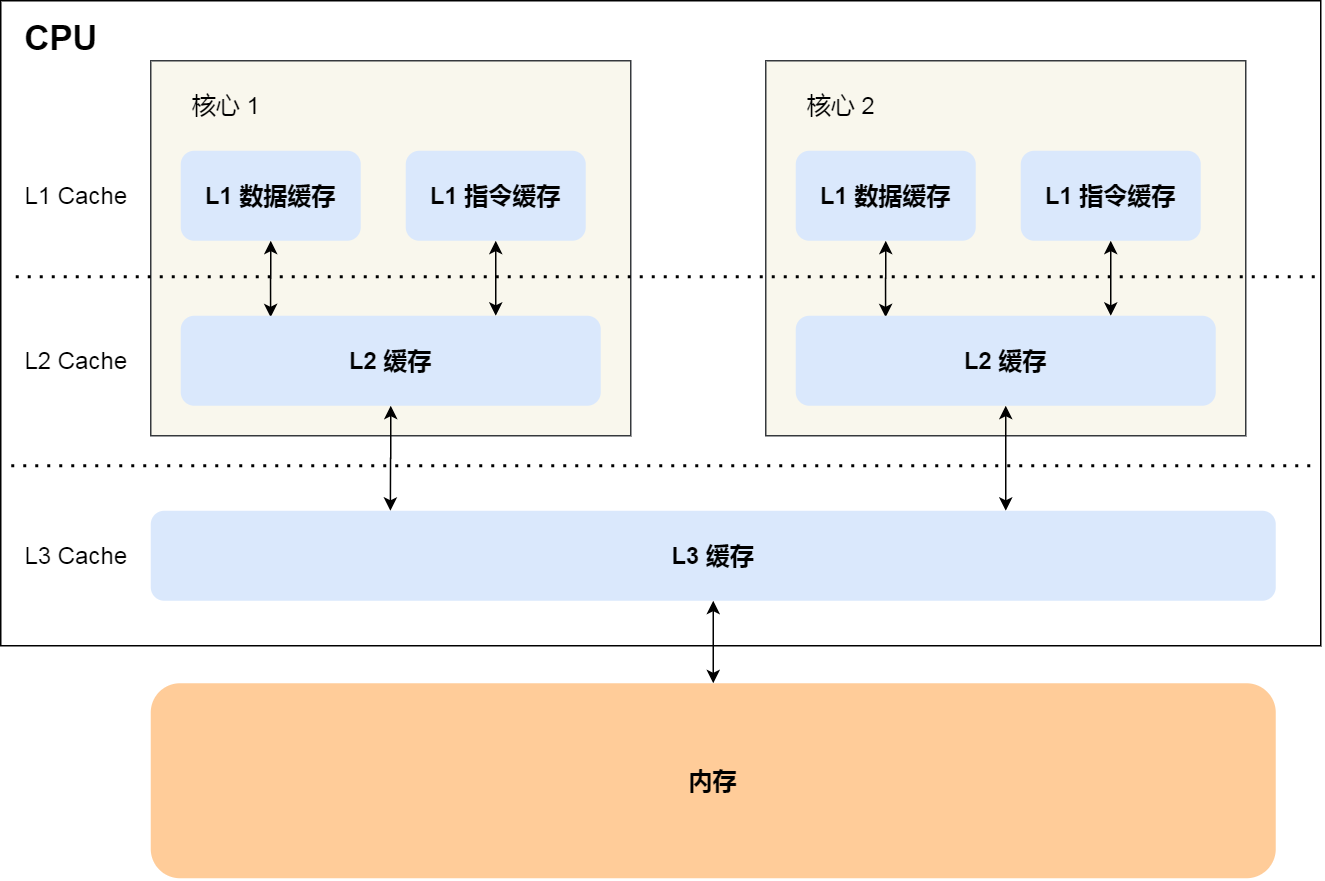

为什么Go中没有volatile

[!info] java中volatile的作用

- 保证可见性(Visibility):当一个变量被声明为

volatile时,当一个线程修改了这个变量的值,其他线程能立即看到这个变量的最新值。这是因为volatile变量的值会被立即写入主内存,并且其他线程读取该变量时会直接从主内存中读取,而不是从线程的本地缓存中读取。- 禁止指令重排序(Prevent Reordering):

volatile关键字可以防止编译器对被声明为volatile的变量进行指令重排序优化。这样可以确保程序的执行顺序符合程序员的预期。==但是这里并不保证原子性,不能直接上多写== 总的来说,volatile关键字适用于那些多线程环境下一个线程写,多个线程读的简单场景,主要用于保证可见性和禁止指令重排序。

- 这个问题一般是写java问写go的,cpp的通常不会这样问

- Go 的基本设计思想是

"Do not communicate by sharing memory; instead, share memory by communicating.",换言之,Go 并不推荐我们在内存中使用共享变量 flag 的形式来实现通信,而是利用 channel 来实现通信,核心的区别点是设计理念上的区别

json.RawMessage

- 用于有时候需要根据type在具体决定解析到哪个结构体的情况下使用,一般不用interface{},因为parse会出错,使用这个替代interface,然后使用Unmarshal直接解析不需要断言

type Obj struct {

Type ObjType `json:"type,omitempty"`

Property json.RawMessage `json:"property,omitempty"`

}

// 然后

func parseBlock(obj *Obj) (block *Block, err error) {

block = &Block{}

err = json.Unmarshal(obj.Property, block)

if err != nil {

return nil, err

}

return

}

需要make初始化结构体

- map

- chan

- 其他的类似切片的用不用都可以

格式化工具

源码阅读工具

- https://github.com/TrueFurby/go-callvis.git 或者

go install github.com/ofabry/go-callvis@latest

代码规范

- #代码规范

命名

- 包名称:

- Go 包名称应该简短并且只包含小写字母。由多个单词组成的包名称应全部小写。例如,包 tabwriter 不应该命名为 tabWriter 、 TabWriter 或 tab_writer

- 避免使用无意义的包名称,例如 util 、 utility 、 common 、 helper,很容易造成导入冲突

- 接收者命名(this指针的名称):

- 短(通常是一两个字母的⻓度) 类型本身的缩写 始终如一地应用于该类型的每个接收者

- 常量命名:

- 常量名称必须像 Go 中的所有其他名称一样使用 混合大写字母MixedCaps。导出常量以大写字母 开头,而未导出的常量以小写字母开头。常量名称不 应是其值的派生词,而应该解释值所表示的含义。

- ==不要使用非混合大写常量名称或带有 K 前缀的常量==。

- 在具有多个首字母缩写的名称中(例如 XMLAPI 因为它包含 XML 和 API ),给定首字母缩写中 的每个字母都应该具有相同的大小写,但名称中的每个首字母缩写不需要具有相同的大小写

- 在带有包含小写字母的首字母缩写的名称中(例如 DDoS 、 iOS 、 gRPC ),首字母缩写应该像在 标准中一样出现,除非你需要为了满足 导出 而更改第一个字母。在这些情况下,整个缩写词应 该是相同的情况(例如 ddos 、 IOS 、 GRPC )

- Get方法:

- 函数和方法名称不应使用 Get 或 get 前缀,除非底层概念使用单词“get”(例如 HTTP GET)。此 时,更应该直接以名词开头的名称,例如使用 Counts 而不是 GetCounts 。

- 变量名:

- 一般的经验法则是,名称的⻓度应与其范围的大小成正比,并与其在该范围内使用的次数成反比。在 文件范围内创建的变量可能需要多个单词

- ==除第一个单词外,每个单词都以大写字母开头==

- 函数接收者变量:

- 使用一个字母或两个字母的名称。

[!tip] 参考 https://github.com/xxjwxc/uber_go_guide_cn 社区认可的 https://gocn.github.io/styleguide/docs/01-overview/ google的 effect-go GO官方的

如何避免Go语言的100个错误

错误检查工具

- vet 标准Go分析工具

- kisielk/errcheck 错误检查工具

- fzipp/gocyclo 循环复杂度分析工具

- goconst 重复字符串常量分析工具

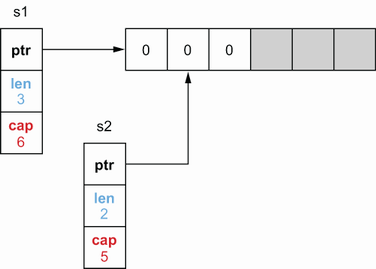

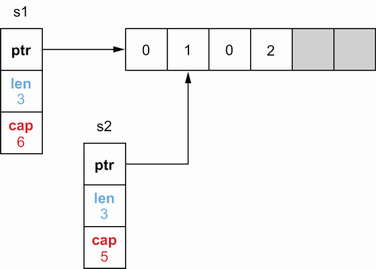

切片注意事项

s1 := make([]int, 3, 6)

s2 := s1[1:3]

- 执行插入一个元素后,这个对于锁

- 是不可见的,因为s2的len没有改变

s2 = append(s2, 2)

// 此时

s1=[0 1 0], s2=[1 0 2]

- 插入多个元素后会地址发生改变

for注意事项

- 下面这个example中 v 会进行复用,因此每次获得的 v 的地址是完全相同的

type A struct {

A string

}

func ForTest() {

testData := []A{

{"1"}, {"2"},

}

target := []*A{}

for _, v := range testData {

target = append(target, &v)

}

log.V2.Info().Obj(target).Emit()

}

// [0xc0002cb470 0xc0002cb470]

// [{"A":"2"},{"A":"2"}]

下载最新版本Go

- 卸载原来的go

apt remove golang-go - 下载安装包从 Go下载 - Go语言中文网 - Golang中文社区

rm -rf /usr/local/go && tar -C /usr/local -xzf go1.14.3.linux-amd64.tar.gz版本自己更改export PATH=$PATH:/usr/local/go/bin添加目录

gin

middleware顺序

- middleware的顺序是按照注册的顺序正序执行,而不是倒序执行

a || b && c

- 这种情况下相当于 a || (b && c) ,所有语言都是一样的, 核心是因为 and 的优先级高于 or

Cors 跨域

- 这个一定得放在 根 g 的 use 中, 不能放在子的api 的 use 中, 否则无法访问

//跨域

func Cors() gin.HandlerFunc {

return func(c *gin.Context) {

c.Writer.Header().Set("Access-Control-Allow-Origin", "*")

c.Writer.Header().Set("Access-Control-Allow-Methods", "GET, POST, PUT, DELETE")

c.Writer.Header().Set("Access-Control-Allow-Headers", "Content-Type, Authorization")

c.Writer.Header().Set("Access-Control-Allow-Credentials:", "true")

if c.Request.Method == "OPTIONS" {

c.AbortWithStatus(204)

return

}

c.Next()

}

}

gdb调试

- 编译

go build -gcflags "-N -l"

-

gdb调试

加载

调试out

- gdb a.out

调试core

- 生成core

ulimit -c unlimited(只对一个终端有用) # 如果设置了没生成用这个看下生成的目录 cat /proc/sys/kernel/core_pattern # 如果想生成当前目录或者没权限 sudo sysctl -w kernel.core_pattern=core # 临时改为生成 core 文件- gdb (程序名) (core名字)

调试程序

- gdb attach pid

运行

带着gui

- gdb -tui (a.out)

设置arg

- set args 运行时参数

常用

- r 开始运行

- c 运行到断点

- n 下一步

- s 进入函数

- until 跳出循环

- fin 结束函数

- bt backtrace 显示当前调用堆栈

- where 查看core目前位置的调用栈

打印

源代码打印

- list num(打印num行附近代码)

- list 打印代码,一直回车一直打

变量打印

- print (打印一切)

断点

设置

- b 11(普通断点)

- b 11 if some>=0(条件断点)

- tb 11(临时断点,只用一次失效)

删除断点

- delete (可以指定断点编号)

查看断点

- info break

多线程

查看线程信息

- info thread

切换线程

- thread id

查看调用帧

- info frame

- backtrace

显示汇编

修改布局

- layout asm

显示函数汇编

- disas /m functionname

查看目前汇编

- x/i $pc

- display /3i $pc

i line 13 disassemble 0x4004e9, 0x40050c退出 q

dlv调试

- 进入包目录

dlv debug

- 其他和gdb差不多

底层结构

数组

- 使用数组,每次作为函数参数会复制整个数组

- 不同大小数组类型不一样,长度不可变

切片

type SliceHeader struct {

Data uintptr

Len int

Cap int

}

- 切片append之后,由于Data内容可能发生变化,所以要切片重新赋值

- 切片作为参数时候,会拷贝结构体内容,因此修改本体

注意,作为参数传递时候,如果是append可能导致data指向发生变化导致外围无法感知变化,因此如果要修改最好还是传指针

func Temp(slice []string) {

slice = append(slice, "1")

fmt.Println(slice)

}

func TryAppend() {

var slice []string

Temp(slice)

fmt.Println(slice)

}

// 这部分代码结果为 [1] []

func Temp(slice *[]string) {

*slice = append(*slice, "1")

fmt.Println(*slice)

}

func TryAppend() {

var slice []string

Temp(&slice)

fmt.Println(slice)

}

// 这部分代码结果为 [1] [1]

和数组区别

- 数组长度不能改变,初始化后长度就是固定的;切片的长度是不固定的,可以追加元素,在追加时可能使切片的容量增大

- 函数调用时的传递方式不同,数组按值拷贝,slice按只拷贝指针

- unsafe.sizeof的取值不同,unsafe.sizeof(slice)返回的大小是切片的描述符,不管slice里的元素有多少,返回的数据都是24字节。unsafe.sizeof(arr)的值是在随着arr的元素的个数的增加而增加,是数组所存储的数据内存的大小。

- 初始化方式不同

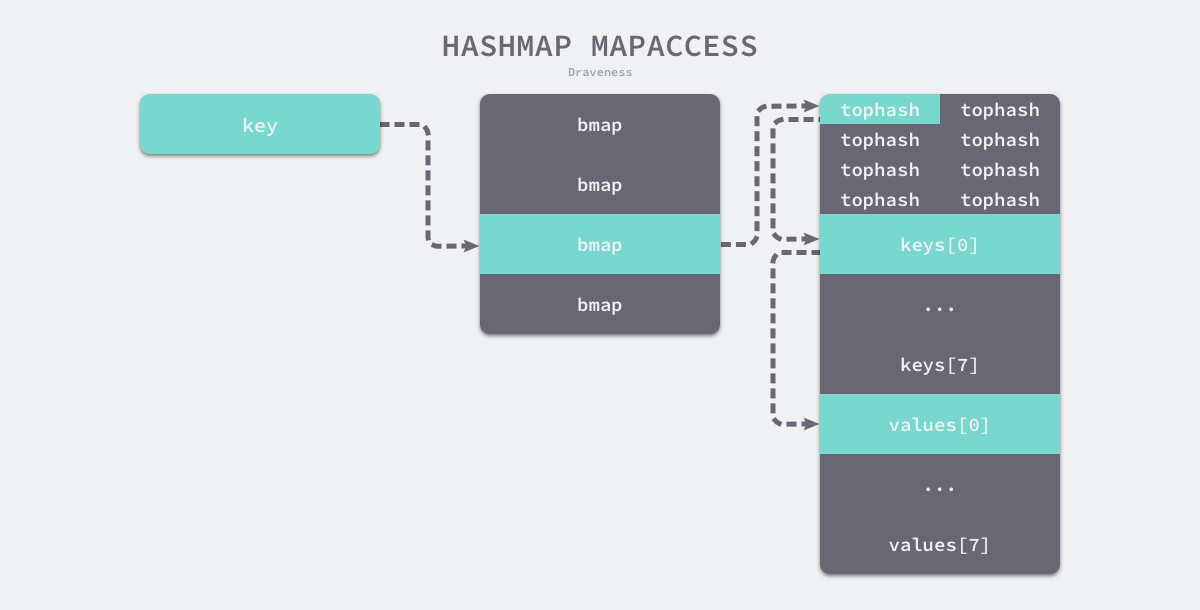

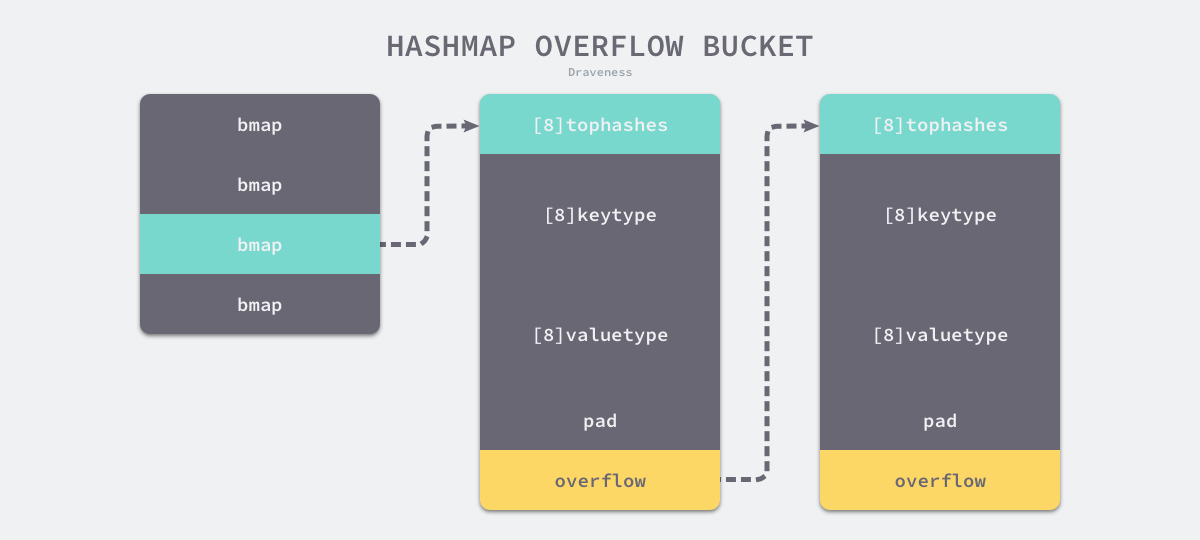

Map

type hmap struct {

count int

flags uint8

B uint8

noverflow uint16

hash0 uint32

buckets unsafe.Pointer

oldbuckets unsafe.Pointer

nevacuate uintptr

extra *mapextra

}

type mapextra struct {

overflow *[]*bmap

oldoverflow *[]*bmap

nextOverflow *bmap

}

-

使用公共溢出区解决hash冲突

- 空间利用效率高(不需要存储指针)2.内存连续性3.灵活的动态扩展

-

实际上存的也是指针,参数会改变

-

只有 hash 后的值相等以及字面值相等,才被认为是相同的 key。很多字面值相等的,hash出来的值不一定相等,比如引用。

-

线程不安全:在查找、赋值、遍历、删除的过程中都会检测写标志,一旦发现写标志置位(等于1),则直接 panic。赋值和删除函数在检测完写标志是复位之后,先将写标志位置位,才会进行之后的操作

-

也是通过渐进式扩容,和redis类似,#### rehash

服务器目前没有在执行 BGSAVE 命令或者 BGREWRITEAOF 命令, 并且哈希表的负载因子大于等于

1; 服务器目前正在执行 BGSAVE 命令或者 BGREWRITEAOF 命令, 并且哈希表的负载因子大于等于5- 渐近式,不会出现突发性能问题(还是用空间换时间)

- 按照倍数扩大

过程

- 为

ht[1]分配空间, 让字典同时持有ht[0]和ht[1]两个哈希表。 - 在字典中维持一个索引计数器变量

rehashidx, 并将它的值设置为0, 表示 rehash 工作正式开始。 - 在 rehash 进行期间, 每次对字典执行添加、删除、查找或者更新操作时, 程序除了执行指定的操作以外, 还会顺带将

ht[0]哈希表在rehashidx索引上的所有键值对 rehash 到ht[1], 当 rehash 工作完成之后, 程序将rehashidx属性的值增一。 - 随着字典操作的不断执行, 最终在某个时间点上,

ht[0]的所有键值对都会被 rehash 至ht[1], 这时程序将rehashidx属性的值设为-1, 表示 rehash 操作已完成。

- 标识开始hash,在每次操作时候进行,按照顺序

- 均为单线程操作

操作

- 查找先在原来的查,找不到再查新的,删除,改变归同时操作两个

- 增加只在新的增加

字符串

type StringHeader struct {

Data uintptr

Len int

}

// byte

type SliceHeader struct {

Data uintptr

Len int

Cap int

}

- 字符串不能更改,只能重新赋值(修改指针,类似+这种都是生成新的字符串)

- []byte(string)实际上发生了拷贝,而不是指针转移,因此开销很大

- 也是线程不安全

接口

- 接口不是任意类型,它自己带有数据,!=nil

// 不带有方法(函数)的接口

type eface struct { // 16 字节

_type *_type

data unsafe.Pointer

}

type _type struct {

size uintptr //用于计算占用大小

ptrdata uintptr

hash uint32 //重要,用于用hash计算两个对象是否相等

tflag tflag

align uint8

fieldAlign uint8

kind uint8

equal func(unsafe.Pointer, unsafe.Pointer) bool

gcdata *byte

str nameOff

ptrToThis typeOff

}

// 带的接口

type iface struct { // 16 字节

tab *itab

data unsafe.Pointer

}

type itab struct { // 32 字节

inter *interfacetype

_type *_type

hash uint32 //和上面的hash一样

_ [4]byte

fun [1]uintptr //重要,虚函数指针

}

-

类型断言实际上就是比较hash值是否相同

-

方法调用时候的操作和C++类似,虚函数加偏移## 多态的实现

虚函数表

- 虚函数表可以理解为就是一个函数指针数组

functype ptr[] - 虚函数表内部存放的是函数指针,而不是函数地址

- 无论是基类还是子类,(前提有虚函数)都有一个自己的虚函数表,继承时候会直接复制基类的虚函数表

- 重写时候会改写虚函数表里面指针指向的函数地址,达到多态作用

- 子类添加新的虚函数(不是重写,而是新的)会追加在虚函数表最后

- 父类指针拿到子类对象时候,对着表格拿到函数指针,但是实际上拿到的是子类的虚函数表,因此函数指针也是指向子类的,因此实现多态

- 多重继承时候会有多个虚函数表

面向过程区别

- 面向对象是以功能来划分问题,而不是以步骤解决

三大特性

封装

- 类仅仅通过有限的方法暴露必要的操作,也能提高类的易用性

- 增强代码可读性和可维护性

继承

- 代码复用,将这些相同的部分,抽取到父类中,让两个子类继承父类

[!tips] 注意点 继承的时候所有虚函数不要加const, 因为不确定子类重写的时候会不会需要更改, 加上是不合适的

多态

- 提高了代码的可扩展性。

- 只需要根据父类指针调用函数,不用关心子类的具体实现

底层模型

虚拟继承

- 解决菱形继承的问题

- A作为base类会被放在最下面,作为共享部分,然后与base不同部分放在上面

D VTable +---------------------+ | vbase_offset(32) | +---------------------+ struct D | offset_to_top(0) | object +---------------------+ 0 - struct B (primary base) | RTTI for D | 0 - vptr_B ----------------------> +---------------------+ 8 - int bx | D::f0() | 16 - struct C +---------------------+ 16 - vptr_C ------------------+ | vbase_offset(16) | 24 - int cx | +---------------------+ 28 - int dx | | offset_to_top(-16) | 32 - struct A (virtual base) | +---------------------+ 32 - vptr_A --------------+ | | RTTI for D | 40 - int ax | +---> +---------------------+ sizeof(D): 48 align: 8 | | D::f0() | | +---------------------+ | | vcall_offset(0) |x--------+ | +---------------------+ | | | vcall_offset(-32) |o----+ | | +---------------------+ | | | | offset_to_top(-32) | | | | +---------------------+ | | | | RTTI for D | | | +--------> +---------------------+ | | | Thunk D::f0() |o----+ | +---------------------+ | | A::bar() |x--------+ +---------------------+多线程

- 当一个thread对象既没有detach也没有join时候,thread释放(可以是因为栈对象自动释放)后会直接中断程序

- thread提供参数之后不能通过引用传递,但是可以通过指针传递,因为thread构造参数时候直接使用拷贝

- condition_variable的wait调用后,会先释放锁,之后进入等待状态;当其它进程调用通知激活后,会再次加锁

std::unique_lock和std::lock_guard类似,第一个更加灵活,但是性能更加差- 条件变量的用法通常为生产者消费者模型,多个线程用同一个锁+条件变量阻塞

- bind函数可以将函数和参数进行绑定生成一个新的函数对象,这样适配接口就会更加方便

void fun1(int n1, int n2, int n3) { cout << n1 << " " << n2 << " " << n3 << endl; } struct Foo { void print_sum(int n1, int n2) { std::cout << n1+n2 << '\n'; } int data = 10; }; int main() { //_1表示这个位置是新的可调用对象的第一个参数的位置 //_2表示这个位置是新的可调用对象的第二个参数的位置 auto f1 = bind(fun1, _2, 22, _1); f1(44,55); Foo foo; auto f = std::bind(&Foo::print_sum, &foo, 95, std::placeholders::_1);// 第二个参数必须是对象作为this指针 f(5); // 100 }- thread是可以移动的move,但是不能复制copy

条件变量和信号量的区别

- 条件变量支持广播方式唤醒等待者;而信号机制不支持,只能一个一个通知

- 条件变量只能结合互斥量做同步用;信号机制除了做同步,还能用于共享资源并发访问加锁

- 条件变量是无状态的,如果唤醒早于等待,则唤醒会丢失;信号机制是有状态的,可以记录唤醒的次数

多线程demo

class ThreadPool{ private: std::queue<std::function<void(void)>> task_que_; std::condition_variable cond_;// 条件变量,通常和锁一起使用 std::mutex que_mut_;// 队列锁 std::vector<std::thread> arr_thread_; std::atomic<bool> is_close; std::atomic<int> busy_num_;// 多线程操作,原子变量 public: ThreadPool(int thread_num){ is_close=false; for (int i = 0; i < thread_num; i++) { arr_thread_.emplace_back(std::thread(Consumer,this));// 本身就是右值,可以不适用std::move,如果是左值而且使用emplace_back的话需要std::move避免thread的复制行为 } } ThreadPool():ThreadPool(5){} ~ThreadPool(){ is_close=true; cond_.notify_all(); for(auto& thread_now:arr_thread_){ thread_now.join(); } } void Add(const std::function<void(void)>& call_back){ std::lock_guard<std::mutex> guard(que_mut_); task_que_.emplace(call_back); cond_.notify_one(); } private: static void Consumer(ThreadPool* pool){ if (pool==nullptr) { return; } auto& cond=pool->cond_; auto& mut=pool->que_mut_; std::function<void(void)> task{nullptr}; while (1) { {// 这个作用域结束que_mut_自动释放,为了避免锁的占用 std::unique_lock<std::mutex> unique(pool->que_mut_); cond.wait(unique,[&]()->bool{return !pool->task_que_.empty()||pool->is_close;});// wait函数首先通过第一个参数拿到锁的控制权,然后不会加锁或者解锁,会等待条件变量的到来,条件变量到来后尝试加锁(多个线程最后只有一个能拿到锁),拿到之后判断第二个参数是否为true,如果为true就继续执行,否则就解开锁继续等待 if (pool->is_close) { return; } task=pool->task_que_.front(); pool->task_que_.pop(); } pool->busy_num_++; if (task!=nullptr) { task(); } pool->busy_num_--; } } }; void PrintFunc(int print_num){ std::cout<<"run:"<<print_num<<std::endl; } int main() { ThreadPool pool; for (int i = 0; i < 20; i++) { pool.Add(std::bind(PrintFunc,i));// std::bind的作用是生成一个新的函数对象,这个对象可以直接提供参数,达到参数简化的目的 } sleep(2); return 0; }

参考

- 深度探索C++对象模型

- 虚函数表可以理解为就是一个函数指针数组

函数调用

- 和C一样的地方:重后向前计算参数

- 不一样:GO不用寄存器,而C用

关键字

for range

for i,v := range arr{}

//会转化为下面形式,长度在一开始就确定了,不会变

//`range` 运算符会创建了数组的副本。同时,循环不会更新副本

ha := a

hv1 := 0

hn := len(ha)

v1 := hv1

for ; hv1 < hn; hv1++ {}

- hash遍历顺序是不确定的

select

- 随机生成一个遍历的轮询顺序

pollOrder并根据 Channel 地址生成锁定顺序lockOrder; - 根据

pollOrder遍历所有的case查看是否有可以立刻处理的 Channel;- 如果存在,直接获取

case对应的索引并返回; - 如果不存在,创建

runtime.sudog结构体,将当前 Goroutine 加入到所有相关 Channel 的收发队列,并调用runtime.gopark挂起当前 Goroutine 等待调度器的唤醒;

- 如果存在,直接获取

- 当调度器唤醒当前 Goroutine 时,会再次按照

lockOrder遍历所有的case,从中查找需要被处理的runtime.sudog对应的索引;

defer

- 底层为链表结构,添加的反而时候会在头部添加最新的defer,执行时候从头执行,类似栈

- 如果是传递参数的话,添加时候(声明defer)函数的参数就已经确定了

- defer和goroutine关联,panic只会调用自己协程的defer

- defer在函数退出时才能执行,在for执行defer会导致资源延迟释放,不要在循环中使用defer,除非构造局部函数

- defer如果是直接接受对象的函数,会立刻拷贝这个对象,如果是对象实体,那么后续改变不影响defer内容,如果是对象指针,后面会影响defer内容

[!important] Defer坑点

... if(xxx){ mut.lock() defer mut.unlock() defer fmt.Println(1) } fmt.Println(2)这段代码的结果是

21,而且因为这个特性很容易产生死锁,defer的调用是在其所在函数返回的时候才会发生的,其他时候不会出现,即使再加个大括号也不行

panic/recover

- 之后defer可以捕获panic并执行recover >在 panic之后不执行,因此不能放后面 >放前面panic没发生,捕获不到

- recover不能跨栈(必须统一层次)执行

func main() {

defer func() {

recover()// 只有放到这里才能执行

}()

panic(1)

}

break

- break+标签的方式作用不是goto 标签,而是跳出标签下的第一个select/switch/for 循环,goto+标签 才是直接跳到该标签

- break只能跳出一个 select/switch/for 循环

- 单独在select中使用break和不使用break没有啥区别。

- 单独在表达式switch语句,并且没有fallthough,使用break和不使用break没有啥区别。

- 单独在表达式switch语句,并且有fallthough,使用break能够终止fallthough后面的case语句的执行。

- 带标签的break,可以跳出多层select/ switch作用域。让break更加灵活,写法更加简单灵活,不需要使用控制变量一层一层跳出循环,没有带break的只能跳出当前语句块。

系统组件

Mutex

正常模式

- 非公平锁

- 正常模式下,所有等待锁的 goroutine 按照 FIFO(先进先出)顺序等待。唤醒 的 goroutine 不会直接拥有锁,而是会和新请求 goroutine 竞争锁。新请求的 goroutine 更容易抢占:因为它正在 CPU 上执行,所以刚刚唤醒的 goroutine有很大可能在锁竞争中失败。在这种情况下,这个被唤醒的 goroutine 会加入 到等待队列的前面。

- 性能好,因为切换成本低.

饥饿模式

- 公平锁

- 饥饿模式下,直接由 unlock 把锁交给等待队列中排在第一位的 goroutine (队 头),同时,饥饿模式下,新进来的 goroutine 不会参与抢锁也不会进入自旋状 态,会直接进入等待队列的尾部。这样很好的解决了老的 goroutine 一直抢不 到锁的场景。

- 触发条件:当一个 goroutine 等待锁时间超过 1 毫秒时,或者当前 队列只剩下一个 goroutine 的时候,Mutex 切换到饥饿模式。

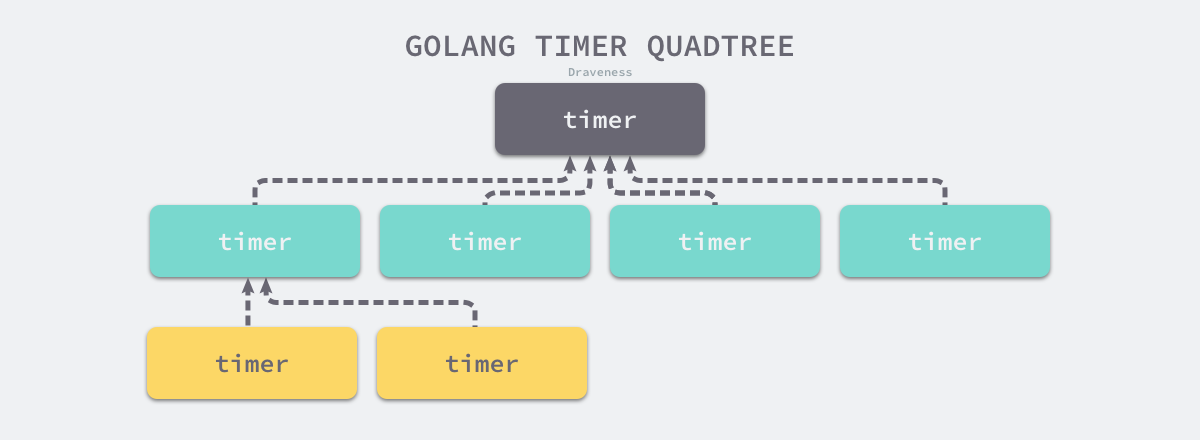

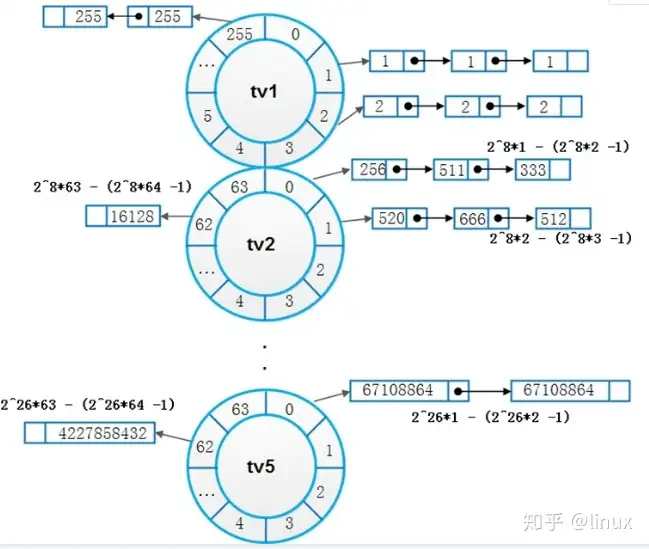

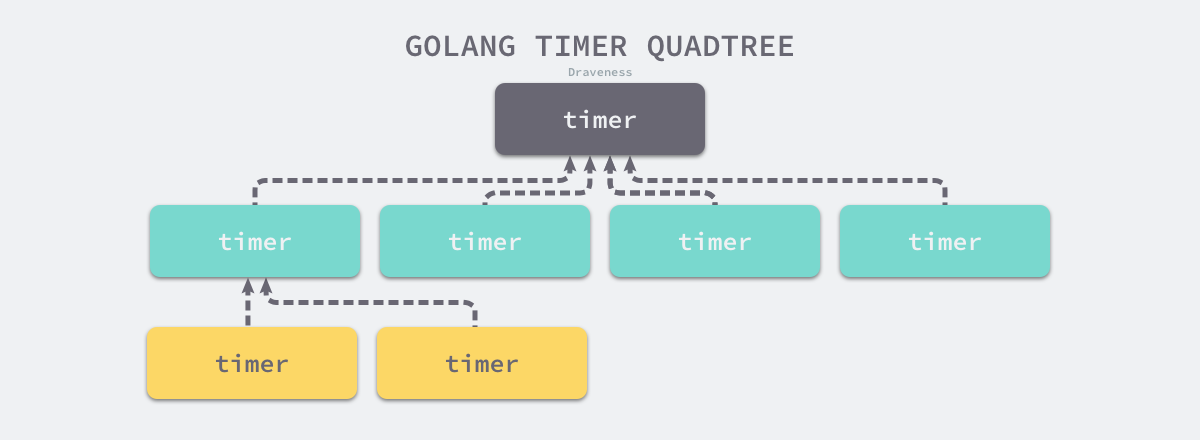

计时器

-

使用四叉堆

时间堆

- 高精度

- 逻辑复杂

- 一般用四叉堆

- 插入和删除的复杂度是logn(因为涉及到排序二分搜索)

思路

- 类似二叉堆,最小先执行的时间放在上面

- 到了实现执行之后重新计算堆

cron

- 使用类似二叉堆的办法

for { // Determine the next entry to run. sort.Sort(byTime(c.entries))// 直接数组排序 var timer *time.Timer if len(c.entries) == 0 || c.entries[0].Next.IsZero() { timer = time.NewTimer(100000 * time.Hour) } else { timer = time.NewTimer(c.entries[0].Next.Sub(now))//计算最小到期时间并且计时 } for { select { case now = <-timer.C://触发标识出现计时器到期 now = now.In(c.location) // Run every entry whose next time was less than now for _, e := range c.entries { if e.Next.After(now) || e.Next.IsZero() { break } c.startJob(e.WrappedJob) e.Prev = e.Next e.Next = e.Schedule.Next(now)//计算下一次触发时间 c.logger.Info("run", "now", now, "entry", e.ID, "next", e.Next) } case newEntry := <-c.add://添加之后会重新计算最小到期时间 timer.Stop() now = c.now() newEntry.Next = newEntry.Schedule.Next(now) c.entries = append(c.entries, newEntry) c.logger.Info("added", "now", now, "entry", newEntry.ID, "next", newEntry.Next) //...略 case id := <-c.remove: timer.Stop() now = c.now() c.removeEntry(id)//删除节点 c.logger.Info("removed", "entry", id) } break//无论结果到这里都会出来重新计算 } }

chan

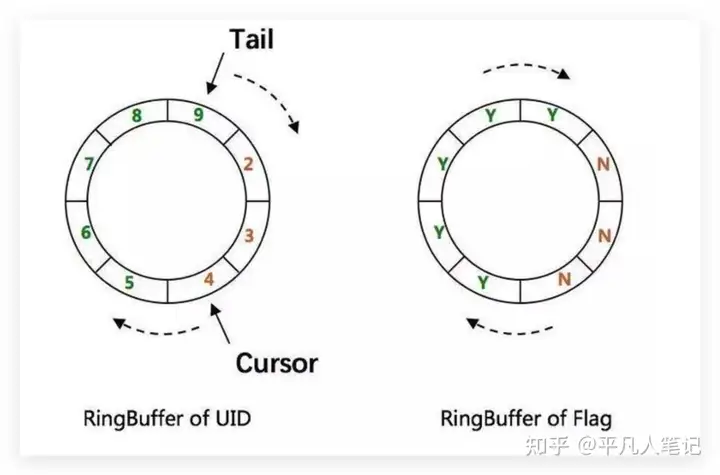

type hchan struct {

qcount uint

dataqsiz uint

buf unsafe.Pointer

elemsize uint16

closed uint32

elemtype *_type

sendx uint

recvx uint

recvq waitq

sendq waitq

lock mutex

}

qcount— Channel 中的元素个数;dataqsiz— Channel 中的循环队列的长度;buf— Channel 的缓冲区数据指针;sendx— Channel 的发送操作处理到的位置;recvx— Channel 的接收操作处理到的位置;

除此之外,

elemsize和elemtype分别表示当前 Channel 能够收发的元素类型和大小;sendq和recvq存储了当前 Channel 由于缓冲区空间不足而阻塞的 Goroutine 列表,这些等待队列使用双向链表runtime.waitq表示,链表中所有的元素都是runtime.sudog结构

- 阻塞发生时候会加入队列后沉睡,然后等待调度器唤醒

- 使用环形缓冲区实现缓冲

发送流程

- 检查 recvq 是否为空,如果不为空,则从 recvq 头部取一个 goroutine,将数据发送过去,并唤醒对应的 goroutine 即可。

- 如果 recvq 为空,则将数据放入到 buffer 中。

- 如果 buffer 已满,则将要发送的数据和当前 goroutine 打包成

sudog对象放入到sendq中。并将当前 goroutine 置为 waiting 状态。

接收流程

- 检查是否有数据,如果有数据,直接返回数据

- 如果没有数据,加入recvq,并且让出协程

关闭的chan

- 向关闭的chan写入会出现panic,重复关闭chan会panic,未初始化关闭会panic(核心就是已经关闭的cha只能读不能写)

- 读取关闭的chan

- 通过val,ok读取得到的ok为false

- 通过val读取得到的为默认值

- close chan时候所有阻塞读chan的协程都会收到消息

- close chan后chan编程只读状态,任何写操作都会panic(比如close和写入消息)

避免产生panic方法

- 应该只在发送端关闭 channel。(防止关闭后继续发送)

- 存在多个发送者时不要关闭发送者 channel,而是使用专门的 stop channel。(因为多个发送者都在发送,且不可能同时关闭多个发送者,否则会造成重复关闭。发送者和接收者多对一时,接收者关闭 stop channel;多对多时,由任意一方关闭 stop channel,双方监听 stop channel 终止后及时停止发送和接收)

for-select模型

- 非阻塞写

for{

select {

case ch <- 1:

fmt.Println("Sent 1")

default:

fmt.Println("Channel is full")

}

}

- 非阻塞读

for{

select {

case i := <-ch:

fmt.Println("Received", i)

default:

fmt.Println("No value received")

}

}

- 退出监控

- 退出时候给所有等待中的chan发送默认值

for {

select {

case <-G2CServer.ExitChan:

return

}

}

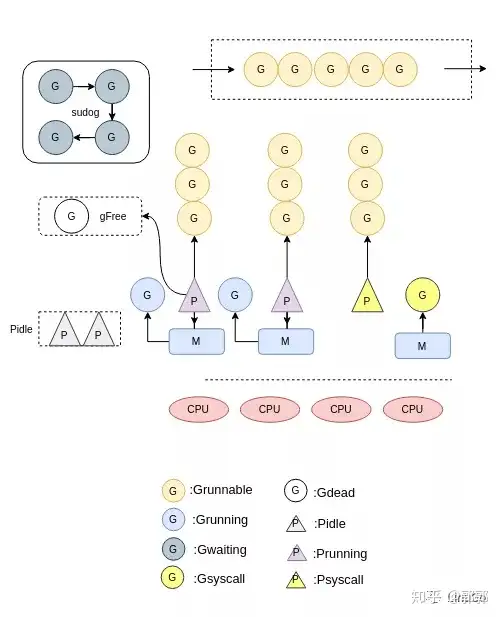

调度器

- goroutine之所以这么快就是因为其比线程更加小,操作系统完全不感知,由Go调度器自己执行和分配而可以做到系统不感知的重要操作是函数调用不需要使用寄存器,这样协程使得所有的操作都在内存进行

GMP模型

- G:表示goroutine,每个goroutine都有自己的栈空间,定时器,初始化的栈空间在2k左右,空间会随着需求增长。

- M:抽象化代表内核线程,记录内核线程栈信息,当goroutine调度到线程时,使用该goroutine自己的栈信息。

- P:代表调度器,负责调度goroutine,维护一个本地goroutine队列,M从P上获得goroutine并执行,同时还负责部分内存的管理。

- 一个M只能同时运行一个G

- M运行哪个G从P获取,P负责G顺序和部分内存的管理,G的运行队列是环形的保证公平

- 再运行GC时候会主动放弃主动权

调度时机

- Channel阻塞:当goroutine读写channel发生阻塞时候,会调用gopark函数,该G会脱离当前的M与P,调度器会执行schedule函数调度新的G到当前M。mutex阻塞也会发生这个情况

- 系统调用:当某个G由于系统调用陷入内核态时,该P就会脱离当前的M,此时P会更新自己的状态为Psyscall,M与G互相绑定,进行系统调用。结束以后若该P状态还是Psyscall,则直接关联该M和G,否则使用闲置的处理器处理该G。

- 系统监控:当某个G在P上运行的时间超过10ms时候,或者P处于Psyscall状态过长等情况就会调用retake函数,触发新的调度。

- 主动让出:由于是协作式调度,该G会主动让出当前的P,更新状态为Grunnable,该P会调度队列中的G运行。

抢占式调度

- 协作式,使用函数触发

- 基于信号,信号触发(目前只在GC使用)

协程同步的方法

- mutex锁

- cond条件变量

- chan通道

- waitgroup

优势

- 上下文切换代价小: P 是G、M之间的桥梁,调度器对于goroutine的调度,很明显也会有切换,这个切换是很轻量的: 只涉及PC SP DX三个寄存器的值的修改;而对比线程的上下文切换则需要陷入内核模式、以及16个寄存器的刷新

- 内存占用小: 线程栈空间通常是2M, Goroutine栈空间最小是2k, golang可以轻松支持10w+的goroutine运行,而线程数量到达1k, 内存占用就到2G。

并发模型

context包作用

- 用于在goroutine 之间传递取消信号、超时时间、截止时间以及一些共享的值

sync包

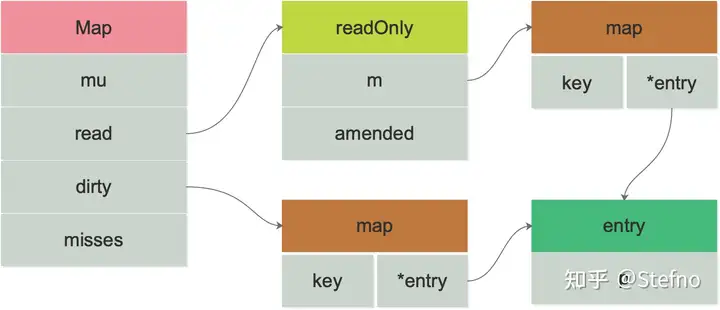

sync.map

- map不是线程安全的(可以通过互斥锁或者读写锁实现线程安全),但是sync.map是线程安全的

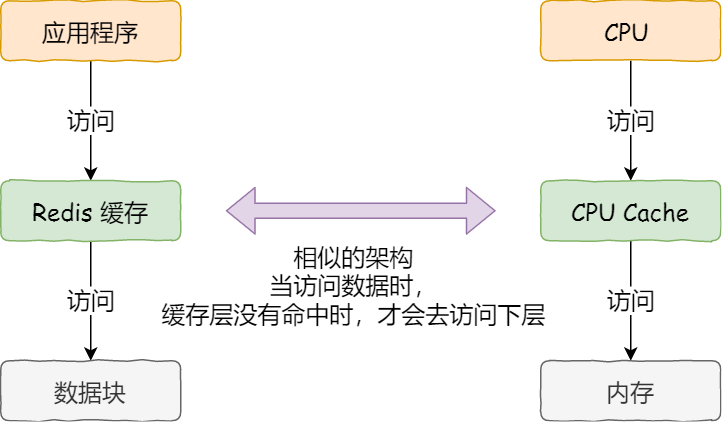

- 底层设计和缓存思想以及redis类似,都是通过缓存读的办法解决读的速度问题,但是写的时候需要维护缓存一致性因此比较慢,合适用于读多写少的情况,非常不适合写多读少的情况,删除因为只是标记,因此也很快.整个设计重点要考虑的就是一致性,和read命中两个方面的问题

结构

type Map struct {

mu Mutex

read atomic.Value // readOnly结构体

dirty map[interface{}]*entry

misses int

}

// Map.read 属性实际存储的是 readOnly。

type readOnly struct {

m map[interface{}]*entry

amended bool //amended 属性告诉程序 dirty 是否包含 `read.readOnly.m` 中没有的数据

}

读取过程

- 先查看 read 中是否包含所需的元素:

- 若有,则通过 atomic 原子操作读取数据并返回。

- 若无,则会判断

read.readOnly中的 amended 属性,他会告诉程序 dirty 是否包含read.readOnly.m中没有的数据;因此若存在,也就是 amended 为 true,将会进一步到 dirty 中查找数据

调用 Load 或 LoadOrStore 函数时,如果在 read 中没有找到 key,则会将 misses 值原子地增加 1,当 misses 增加到和 dirty 的长度相等时,会将 dirty 提升为 read。以期减少“读 miss”

写入过程

- 检查

m.read中是否存在这个元素。若存在,且没有被标记为删除状态,则尝试存储。 - 如果不存在进入dirty

- 加锁,dirty因为是原生的map,加锁才能使用

- 若发现 read 中存在该元素,但已经被标记为已删除(expunged),则说明 dirty 不等于 nil(dirty 中肯定不存在该元素)。其将元素状态从已删除(expunged)更改为 nil。将元素插入 dirty 中。

- 若发现 read 中不存在该元素,但 dirty 中存在该元素,则直接写入更新 entry 的指向。标记amended为true

- 若发现 read 和 dirty 都不存在该元素,则从 read 中复制未被标记删除的数据,并向 dirty 中插入该元素,赋予元素值 entry 的指向

删除过程

- 将 entry.p 置为 nil,并且标记为 expunged(删除状态),而不是真真正正的删除。

参考

- https://zhuanlan.zhihu.com/p/413467399

- https://zhuanlan.zhihu.com/p/344834329

Goroutine泄露

- 泄漏的可能主要分为

- channel 导致的泄露

- 如goroutine等待chan或者发送chan导致不能释放,这部分可以通过context的cancel取消

- 传统同步机制导致的泄露

- 比如多个协程加锁但是没有释放,导致不停等待

- channel 导致的泄露

内存管理

内存分配器

- 类似内存池分配分片式

内存回收GC

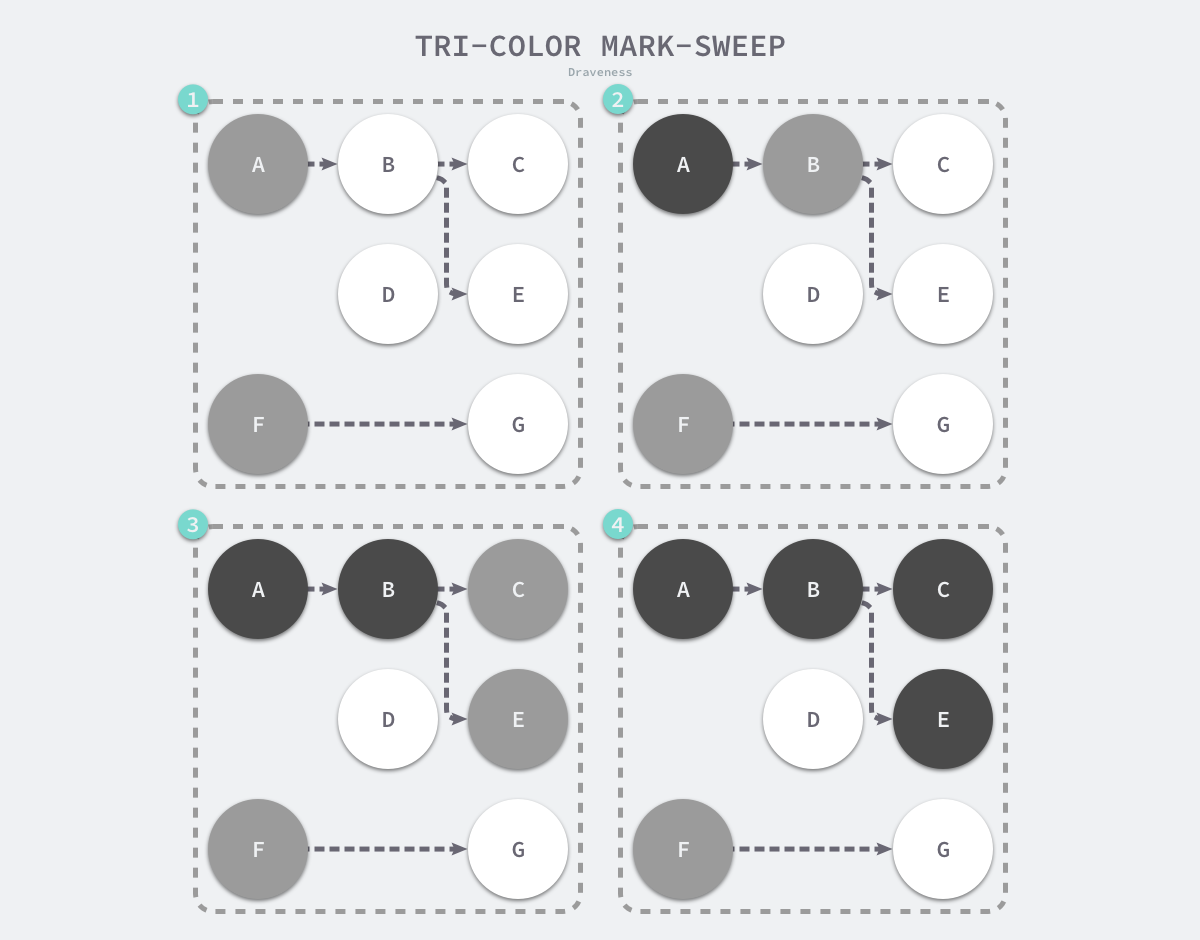

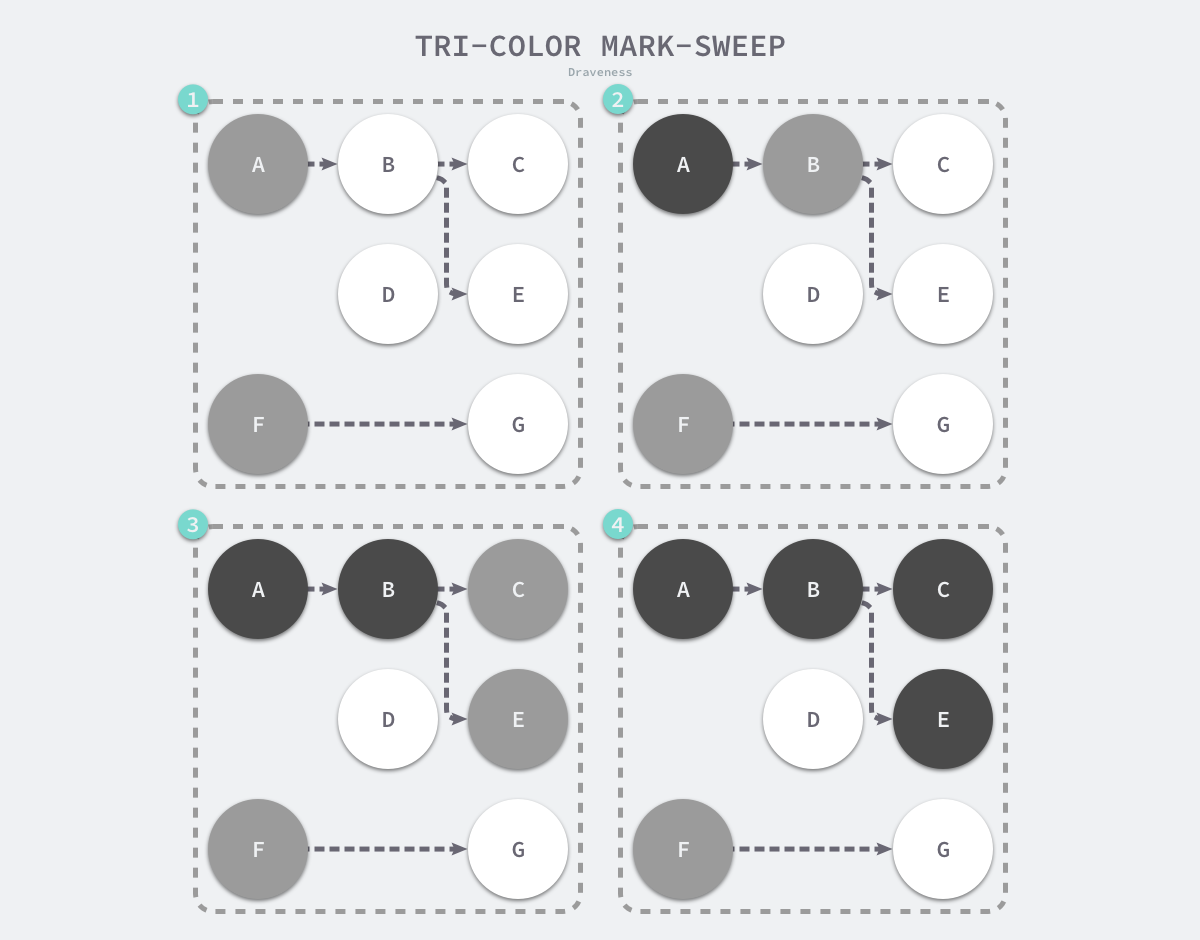

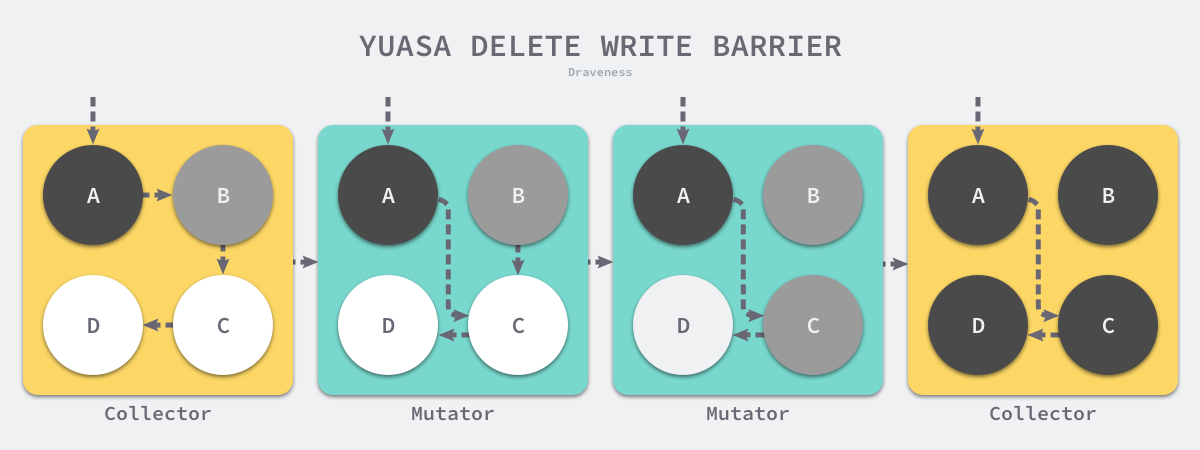

三色标记法

代码参考

- C++:https://gitee.com/chenxuan520/tricolor-notation/blob/master/gc.h

说明

- 本质也是标记清除算法,但是解决它的程序停止的缺点(核心还是读写冲突的问题,如果不暂停程序就会出现读写冲突,三色标记法使用的是类似锁的方法解决)

- 垃圾收集的根对象一般包括全局变量和栈对象,因为栈对象永远是黑色(会自动释放),只有堆对象需要回收

- Go 语言的垃圾收集可以分成清除终止、标记、标记终止和清除四个不同阶段

过程

- 先从根开始标记灰色,三个桶

- 把灰色引用到的全部变灰色,灰色变黑

- 删除白色对象

- 继续上面过程

完整流程

- GCMark 标记准备阶段,为并发标记做准备工作,启动写屏障

- STWGCMark 扫描标记阶段,与赋值器并发执行,写屏障开启并发

- GCMarkTermination 标记终止阶段,保证一个周期内标记任务完成,停止写屏障

- GCoff 内存清扫阶段,将需要回收的内存归还到堆中,写屏障关闭

- GCoff 内存归还阶段,将过多的内存归还给操作系统,写屏障关闭。

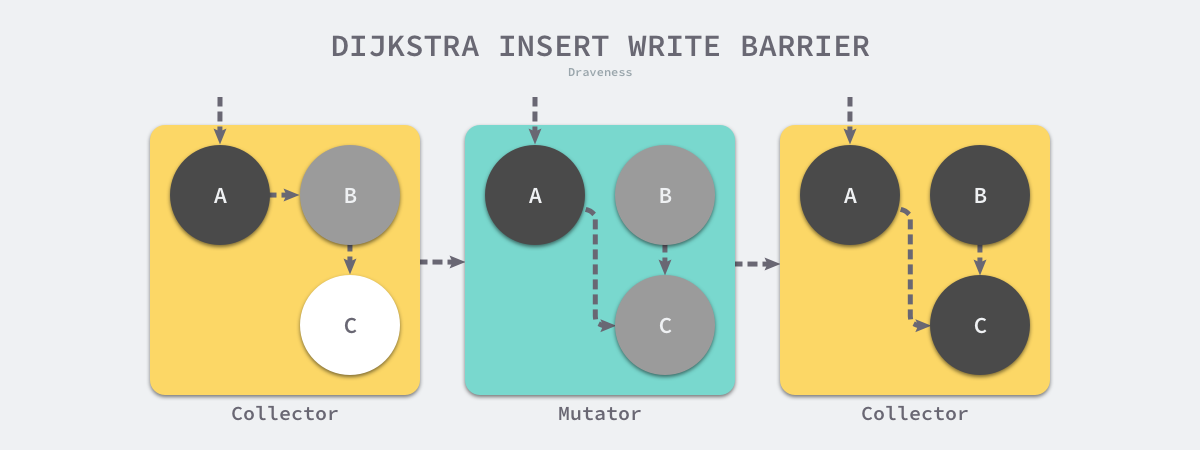

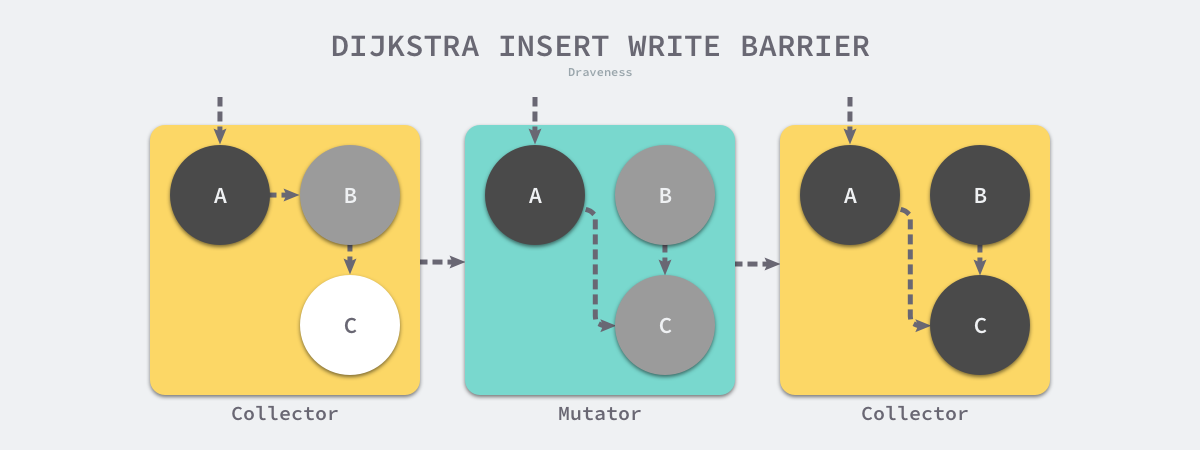

写屏障

- 强三色不变性 — 黑色对象不会指向白色对象,只会指向灰色对象或者黑色对象;

- 弱三色不变性 — 黑色对象指向的白色对象必须包含一条从灰色对象经由多个白色对象的可达路径

- 所有触发都是针对黑色和灰色对象,白色对象引用的改变不会触发

- 缺点: 需要给栈对象添加屏障,损耗指针性能

插入写屏障

writePointer(slot, ptr):

shade(ptr) //把要插入引用的对象先涂灰

*slot = ptr //改变指针到引用

- 把增加引用的对象变成灰色,添加引用时候触发,保证强三色不变性

删除写屏障

writePointer(slot, ptr)

shade(*slot) //把要删除的引用对象涂灰

*slot = ptr //改变指针到引用

- 删除引用之前,先把被删除引用对象涂灰

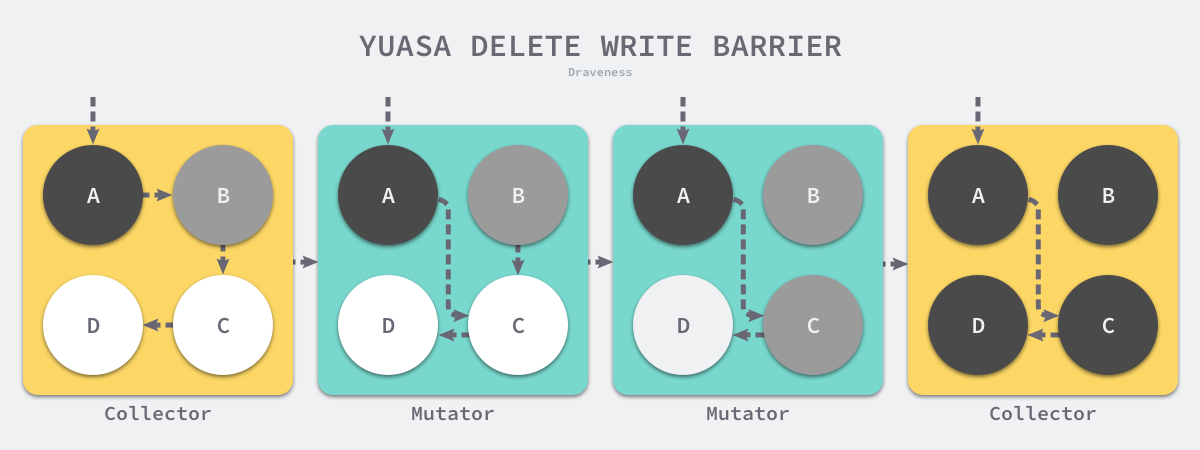

混合写屏障

writePointer(slot, ptr):

shade(*slot)

if current stack is grey://当前栈没有扫描,是白色

shade(ptr)

*slot = ptr

- 将创建的所有新对象都标记成黑色,防止新分配的栈内存和堆内存中的对象被错误地回收

内存逃逸

- 由编译器编译时候生成AST,分析之后得出分配在哪里

原则

- 指向栈对象的指针不能存在于堆中;

- 指向栈对象的指针不能在栈对象回收后存活;

如果函数外部没有引用,则优先放到栈中; 如果函数外部存在引用,则必定放到堆中;

逃逸类型

- 外部引用(类似指针)

- 栈空间不足逃逸(分配过大空间)

- 动态类型逃逸(interface类型,由于编译期间难以确定类型,直接扔到栈上)

参考

- https://zhuanlan.zhihu.com/p/261057034

- https://draveness.me/golang/docs/part3-runtime/ch06-concurrency/golang-goroutine

- https://zhuanlan.zhihu.com/p/113643434 推荐书籍

- Go语言设计与实现

封装

- 封装的私有直接使用的是大小写来判断,关键字都不需要

type Dog struct{

name string

}

func (d Dog) Say() {

fmt.Println("woof")

}

继承(嵌入)

type animal struct {

Name string

}

type Dog struct {

*animal

}

- 嵌入容易产生屏蔽问题

多态

type Animal interface {

Name() string

Speak() string

Play()

}

type Dog struct {

name string

gender string

}

func (d *Dog) Play() {

fmt.Println(d.Speak())

}

func (d *Dog) Speak() string {

return fmt.Sprintf("my name is %v and my gender is %v", d.name, d.gender)

}

func (d *Dog) Name() string {

return d.name

}

func Play(a Animal) {

a.Play()

}

- 底层为和C++类似技术/cpp/面向对象

参考

https://zhuanlan.zhihu.com/p/165621566 https://www.cnblogs.com/apocelipes/p/14090671.html https://www.cnblogs.com/u-vitamin/p/10793554.html https://www.cnblogs.com/dogtwo0214/p/13419080.html

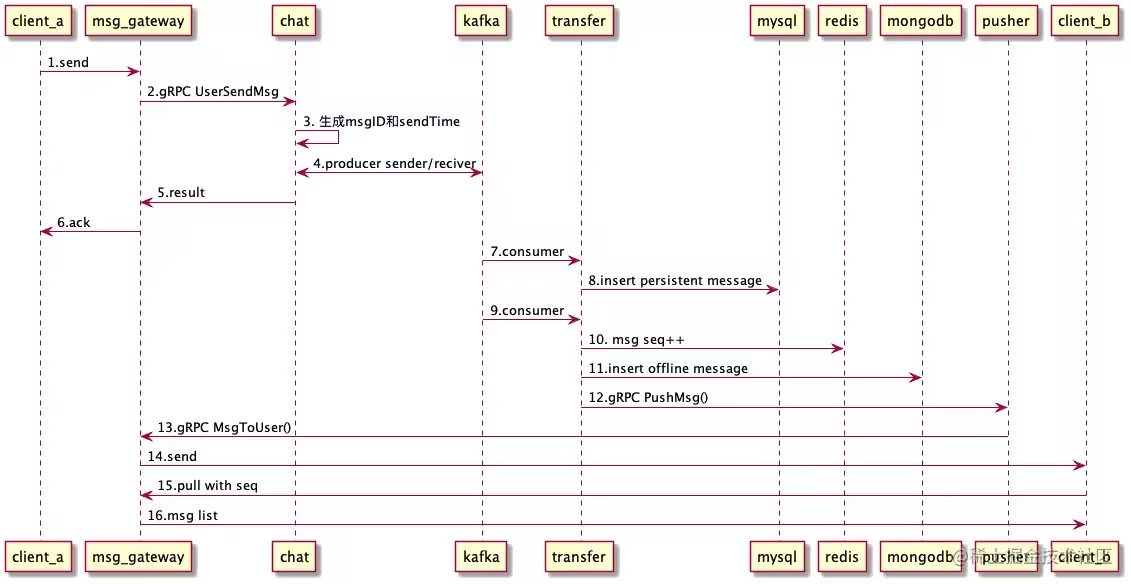

- 小型群聊和普通聊天差不多,只是标记群聊标签,都是写扩散

- 分配seq的方法为使用redis的incr 分布式ID生成 > Redis

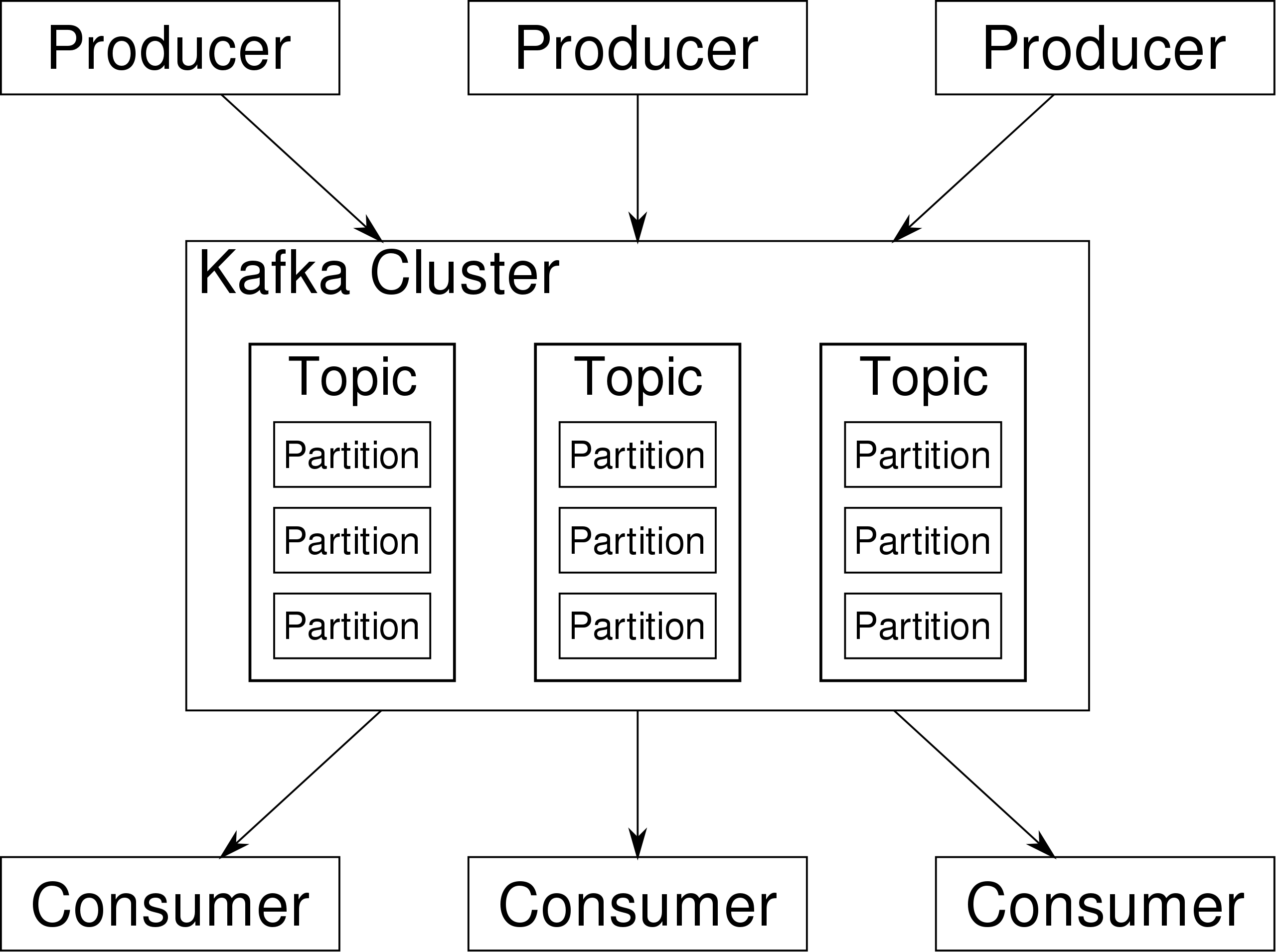

- 上行和下行都使用了kafka消息队列的机制

- kafka参考消息队列

- 使用websocket作为长连接通道

详细流程

- 客户端通过webSocket发送消息到msg_gateway

- msg_gateway通过gRPC调用chat的 UserSendMsg() 发送消息

- chat服务主要是本地生成唯一消息ID(去重)和发送时间

- 然后投递到Kafka,等待所有Kafka的Slave都收到消息后判断发送成,gRPC返回

- 给客户端回复ACK,携带错误码和服务端生成的MsgID等

- transfer中的消费组mysql消费到2条消息(发送者的发件箱、接收者的收件箱)

- 持久化到mysql中全量存储,主要是应对后台分析、审计等需求,客户端是从mongodb中拉取的(拉取后删除),这里和微信逻辑类似。微信号称不在服务器存储数据,所以你用微信登录PC端时,你会发现刚刚手机上的消息在PC上怎么看不到?要么是PC端没有pull的过程,要么是离线消息只针对APP端,PC端拉不到。

- 同理,transfer中消费组mongodb消费到2条消息

- 调用redis的incr,递增用户的消息序号,key格式为:"REDIS_USER_INCR_SEQ: " + UserID,所以是用户范围内递增,因为本身用户只有一个收件箱,没毛病。

- 插入mongodb中的chat collection

- 优先通过gRPC调用pusher进行推送,否则走Kafka,通过Pusher消费的方式推送

- pusher也同样通过gRPC调用msg_gateway的MsgToUser推送消息

- 通过websocket推送

- 用户b上线的时候,通过pull从mongodb中拉取离线消息(成功后会从mongodb中删除)

发送端

- 通过websocket创建长连接,安全性依赖https,没有自定义加密,使用json的[]byte数组结构体接收,gate微服务判断包的类型后发送到rpc微服务

- rpc微服务会将消息使用protobuf格式化后推送进入消息队列中(如果是通知类的消息且在线直接在线),并返回成功(并不会保证落库成功之后才进行返回)

- 从消息队列中拿出有两个消费组分别消费,一个负责mysql的直接落库(如果设置了的话)

- 另外一一个拿出来首先经过一大堆内部的chan缓冲

- 先向redis请求seq,使用redis的incr获取seq

- 插入mongo数据持久存储

- 通过websocket推送消息体(因为这部分的可以保证所有的消息seq连续递增,因此可以保证有序性)

接收端

- 上线的时候和tira-im 类似,都是通过seq和redis+mongo拉取消息

- 启动的时候根据mongo中的最大seq初始化redis中的seq

特点

- mysql,mongodb会分别消费这个topic,一条消息会被消费多次,首先通过redis的自增id,然后将消息体储存到个人的mongodb中

- 使用push模型和个人收件箱(个人和小群),消息堆直接推送到客户端

- 大群使用类似helper-im 使用群收件箱,这个小群和大群似乎是创建群聊的时候设置的而不是后续变化的(这个感觉理论上也很难变化)

唯一性

- redis的原子自增,保证seq不重不漏

- 幂等性保证,依赖kafka的特性(存疑)

必达性

- 实际上这个架构还是可能导致消息的丢失的,因为没有确保落库成功才ack到kafka

有序性

- redis生成的seq保证自增保证有序性,这里的redis扩展的时候可能需要上一致性hash的方法

优缺点

优点

- 似乎mongodb承担了收件箱排序的功能,和缓存的功能,没有进行redis缓存

- push模型,在线直接推body,省略上行拉取的过程

缺点

- 从kafka拿出来后直接标记ok,压根没有判断失败后重试的过程,只打了个日志,这样如果mysql断开连接落库失败,会导致消息的丢失

- 依赖redis的原子incr,如果出现宕机,需要从mongo中恢复最大的序号,redis可能成为一个瓶颈

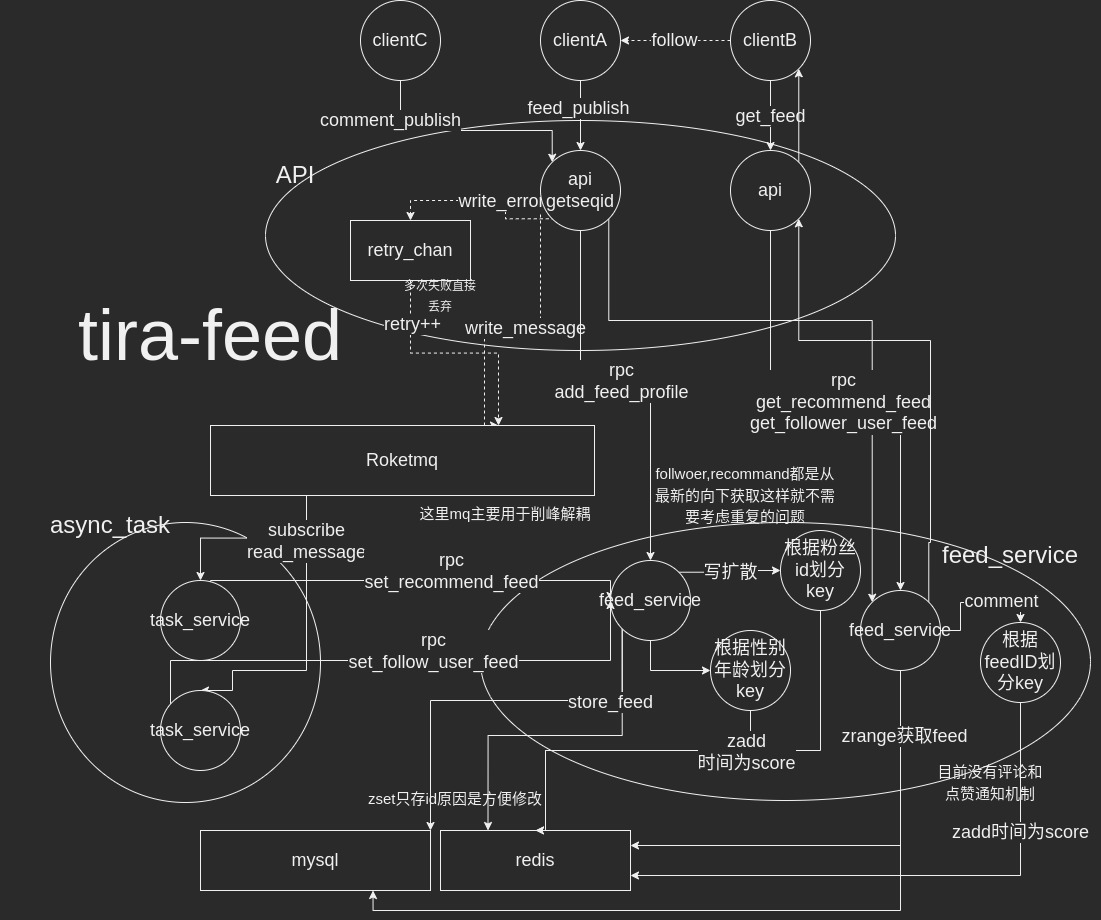

架构图

- feed流根据时间拉取最新的数据,每个用户有一个关注者收信箱,用于关注的feed流

- 每个用户根据年龄和性别划分有一个公共的收信箱,每次拉取的都是最新的和最近的

- roketmq参考消息队列

具体流程

api微服务

- 上传feed流的用户首先通过api微服务http上行请求(格式具体不是json而是protobuf),发号(通过全局发号)

- 通过rpc调用feed微服务,将上传的feed落库,图片和location和内容一共三张表,通过主表标识是否有图片和地理位置

- 通过异步协程,将消息加入消息队列中,如果加入失败,塞到chan重试

- 落库成功后直接返回成功

- 拉取时候先计算个人是属于哪一个zset的推荐流的,算不出就用全局推荐流

task微服务

- 有两个消费者组,推荐流和关注流,每条消息都需要经历两次消费

- 关注流查找所有关注了的人(通过rpc调用),然后异步将feed的id加入个人关注zset队列(每个人都有一个zset)中(写扩散),key为id

- 推荐流先加入全局的feed(通过rpc调用),通过发布者的信息(年龄和性别)分别写入不同的zset(每个属性都有一个zset),key为id,读扩散

feed微服务

- 当拉取个人关注流的时候,直接拉取zset最新的id(也可以offset和limit),(这部分可能有问题,当拉取的时候又有更新,offset和limit是不准确的,而且无法实时同时)

- 拉取推荐流也是类似,先计算个人的属性,拉取最新的feed流

tira

设计图

架构图

时序图

唯一

- 客户端生成ID(通过时间戳作为msgID)

- 服务端使用ID+TO+FROM 唯一标识信息setnx处理幂等性

必达

- 在IM部分的重试队列保证必达

- 服务端回应fin,客户端回应ack,标识受到信息

- 增量拉,避免某条消息丢失

有序

- seqID 递增机制(不连续但是一定自增),号段模式

- 防止seqID号段多次消费使用hash负载均衡使得所有的相同ID落在同一台实例上

- 通过只下发id不下发消息体保证

具体流程

客户端连接

-

请求先打到AWS四层负载均衡器上,然后进入服务器中负责网关的微服务(这部分可以使用nginx代替),微服务通过负载均衡策略将长连接请求打到nginx上

-

和edge-connect建立TCP长连接,生成唯一的tcp-id(自己edge内唯一即可),最好不用socketid,因为socketid复用容易导致出问题,可以维护自增变量(atom)

edge通过edge-id构建redis的消息队列,每个edge都有自己的队列 edge自己有个edge-id(connect-id)用于标识自己是哪个edge

-

edge生成3个协程,一个用于上游消息的阻塞接受,一个用于下行消息BRpop从redis阻塞读取读取到下行消息后放到downstreamchan中等待其他协程处理,一个用于5s心跳包发送保活(每次有消息包来都会重置)

-

将edge-id和tcp-id,以及连接的地址信息加入msg字段向route层发送

-

客户端向服务端发送auth-hello

-

route层先把body中的jwt token拿出来解析,获取uid,通过uid,val为hash,hashkey为resource,在redis检查是否连接已经建立,如果建立下发流冲突断开旧的连接,同时设置过期时间

-

服务端回应auth-reply,参考加密系统 > tira-im加密

-

验证成功后将通过uid,val为hash,hashkey为resource,插入redis,hash-val为tcp-id和edge-id,同时插入redis将tcp-id+edge-id作为key插入redis,val为个人信息和AES密钥,用于route层查找用户

edge全程不感知用户内容,仅仅作为维持长连接工具

数据包发送

-

数据包经过AWS四层负载均衡器打到edge-connect上

-

route先从session拿到对应tcp-id和edge-id对应客户端uid和uid对应的AES-key,然后AES解密得到原始报文,同时更新key的存活时间,应用层保活

这部分session中需要存储两部分的内容,一个是key为uid,val为tcp-id,edge-id等信息,用于保活,另一个是key为tcp-id+edge-id,val为aes密钥,用户获取这个tcp连接的密钥

-

route根据cmd字段分配不同的process同步处理,处理结束之后如果有应答,使用雪花算法生成id组装数据包,马上返回edge层面,edge将其加入downstream chan中下发消息,这部分的逻辑也可以改成插入nsq后立刻返回,inte拿出就返回ok(因为失败毕竟是少数情况,重新放回不会影响太多的性能,避免大量消息因为没有ack而在等待,最重要的是,需要修改字段标记处理阶段和重试次数),如果处理失败修改继续放入队列延迟重试(这部分可能造成消息的积压),向connect中推送也使用(这个一般不涉及处理连接失败和重试,而且这部分消息丢失的代价较小,因此不一定需要使用消息队列),route将数据包放到integration层立刻返回

-

integration拿到消息后进入复杂处理消息逻辑

- 检查消息合法性,是否被拉黑之类,被拉黑先客户端下行系统消息发送失败

- 通过sendid+recvid+clientid作为key,setnx插入redis,作为幂等性判断若插入失败证明信息已经发送,数据库总结 > 幂等性处理,

- 通过gennerator生成seqid(保证有序递增,不要求连续tira-others > gennerator,以个人维度发号)

- 消息落mysql数据库(这里使用to_id作为hash落库,查询自己发的消息麻烦,因此这个模式适合于android自带记录的私聊),这里使用seqid拼recvid作为private_key防止冲突

- 消息落redis,缓存时间为5分钟(这里没有进行判错校验,可能导致重复落mysql库)

- 加入redis的zset队列,seqid为key和val(没有进行判错校验,可能导致zset重复插入一直失败)

- zset队列相当于helper中的收件箱,个人和所有人的对话收件箱都在这里

- 这里注意:如果zset找不到这个key或者查的比里面最小的还小(比如出现宕机现象),需要从数据库拉取之后放入redis缓存容灾

- 获取redis zset最新的seqid,构建syncpull包,先to的所有在线resource发送syncpull,要求其下拉消息

-

syncpull包到route层,查询包中的uid对应的tcpid和stream-id,将消息塞到redis的消息队列中

-

edge从redis拿到消息封装之后塞到downstreamchan中等待发送

消息接受

- 客户端收到syncpull要求之后,检查自己的seqid和服务端发过来的seqid大小,如何自己的比较小,就把自己的seqid作为起始seqid发送syncpull请求

- edge层面直接转发到route层面

- route层面转发到integration层面

- integration层面通过zset找到比客户端seqid大的所有seqid,先在redis中找消息,找不到就去mysql找,找到之后将消息一条一条sendmessage返回到route层面,最后加上一个ack标识消息发送结束(否则客户端不知道消息什么时候发送终止)

- route将每个消息加密之后一个一个塞到redis队列中(每个TCP包大小有限,一次可能发不完,因此一个一个发)

- edge继续塞到downstreamchan等待发送

- 客户端收到消息之后,如果读取之后,上行ack携带读到的seqid

- edge传输到route,继续传输到integration,通过chan异步将redis收件箱中比客户端发的seqid小的都删除(删除收件箱)

数据包

-

edge层面packer头固定长度,先接收一个header,根据长度继续接受packer的body,header头包括版本号和长度等信息

-

除了开始的auth-hello的packer不加密,其他packer的body是加密的,密钥为serran+cliran+sessionid的md5结果

-

解决粘包问题关键,包括tcp中的数据也是这样解决粘包的问题

-

加密后的内容中存在content_type以及body,其中body是使用[]byte类型,根据不同大的type映射到不同的结构体(使用protobuf)

-

具体流程:

- edge首先接受header,根据payloadSize接受,并且将接收到的数据映射到Payload中

- edge将包上传到route的时候,封装成UpstreamMessage,使用包头中的type以及Payload的数据组装

var upstreamPacketWrapper = proto.UpstreamMessage{ ID: packet.Header().ID(), ProtocolVersion: packet.Header().ProtocolVersion(), Command: proto.NewCommandWithData(packet.Header().Command(), packet.Payload().Data()), Resource: packet.Header().Resource(), RemoteAddr: remoteAddr, LocalAddr: localAddr, StreamID: streamID, ConnectorID: connectorID,

}

3. route拿到之后根据type进行分发,并且使用protobuf反射解析到结构体 4. route分发到的不同的微服务

// edge-connector

// Header 包头

type Header struct {

//PacketID 用户空间唯一自增(版本号) 64bits

id uint64 `string:"id"`

//协议版本号 8bits

protoVersion uint8 `string:"proto_version"`

//指令枚举值 8bits

cmd uint32 `string:"cmd"`

//资源标记符:同一组资源需要处理流冲突 8bits

resource uint8 `string:"resource"`

//Payload大小, 最大支持2^31 byte长度数据 32bits

payloadSize uint32 `string:"payload_size"`

}

// Payload 包体

type Payload struct {

size uint32

data []byte

}

// coa-router-service

type UpstreamMessage struct {

//PacketID 用户空间唯一自增(版本号)

ID uint64 `json:"id" msgpack:"id" string:"id"`

//协议版本号

ProtocolVersion protocol.ProtocolVersion `json:"protocol_version" msgpack:"protocol_version" string:"protocol_version"`

//资源

Resource protocol.ClientResource `json:"resource" msgpack:"resource" string:"resource"`

//该包关联的远程以及本地地址,二元组组成唯一的TCP连接

RemoteAddr string `json:"remote_addr" msgpack:"remote_addr" string:"remote_addr"`

LocalAddr string `json:"local_addr" msgpack:"local_addr" string:"local_addr"`

//连接流ID

StreamID uint64 `json:"stream_id" msgpack:"stream_id" string:"stream_id"`

//网关ID

ConnectorID uint64 `json:"connector_id" msgpack:"connector_id" string:"connector_id"`

Command *Command `json:"command" msgpack:"command" string:"command"`

}

type Command struct {

Type protocol.CommandType `json:"type" msgpack:"type" string:"type"`

Data []byte `json:"data" msgpack:"data" string:"data"`

}

难点

- 如何让保证消息的唯一性,客户端有重试机制,大量消息出现时不会出现id重复的问题,宕机重启时候不会出现重复id

- 如何保证消息的有序性,可能出现下行消息的乱序,客户端无法主动解决这个问题,同一个群大量人发送消息时候消息处理的有序

- 如何让保证消息的必达性,弱网情况下下行的消息可能出现丢失错漏的现象,逻辑处理时候可能出现数据库宕机,程序宕机的情况,如何保证必达性

- 如何在多端登录时候下同步消息

- 如何保证消息的安全和隐私性

QA

为什么不使用websocket

- 要求信息加密性要求比较高,实时性要求比较高,因此使用简化版的SSL/TLS达到自协议加密作用加密系统

- 免去http协议升级过程,直接使用TCP连接,更加快速和便捷

- ws在nginx解密,未必到达内部服务可信层

- 公司之前有成熟的设计方案

为什么不使用主键作为seq

- 因为未来设计中群聊功能需要发号.无法使用id作为seq

- 但是这部分会出现群聊消息爆炸导致重要的个人消息拉取慢的问题(因为是一条线,必须先拉去前面的消息才能拉取后面的消息)

为什么不用websocket的保活,需要两个层面保活,如何实现

- session其他服务也需要用,业务层保活必不可少,这两个层面是不一样的,一个代表tcp在线,一个代表用户在线,并不能混用

- session保活依赖redis的自动过期,导致发现的时间长,tcp本地保活发现的时间更加快速,避免无效连接占用堆积的情况

- 缺点是每一个用户都要维护定时器,系统开销增加

//检查当前连接是否存活

//连接存活的机制:

//1) 如果有数据IO,则每一次上行以及下行均会更新activeTime,在30s过期内更新则表示存活

//2) 客户端定期的ping探测机制,能保证至少30s有一次activeTime更新(实际idleTimeout=pingIntervalTime+RT时间)

func (conn *Conn) keepAliveSchedule() {

idleTimeout := conn.srv.config.idleTimeout + conn.srv.config.roundTime

conn.checkTimer = time.NewTicker(idleTimeout)

go func() {

defer conn.checkTimer.Stop()

for {

select {

case <-conn.exitChan:

return

case tm := <-conn.checkTimer.C:

diff := tm.Sub(conn.activeTime)

if diff >= idleTimeout {

logger.Infof("conn[%d] remove staled connection after:%s", conn.ID, idleTimeout.String())

metric.EdgeConnectorCoreMetricReporter.PassiveDisConnCounter()

conn.setState(StateClosed)

conn.Exit()

return

}

}

}

}()

}

- connect层的保活直至维护长连接的状态,session的保活是为了维护用户的登录状态

- wesocket自带保活有以下缺点

- tcp 自带的 keepalive 时间非常久,一般情况业务是不能依赖的,配置在操作系统

- 中间还有个NGINX反向代理服务器,在一段时间内没收到数据也会自动断开连接

- tcp因为是虚拟的,导致没有数据传送时候掉线判断困难,ping/pong让tcp掉线响应更快

- 运营商的NAT,超过5mins没有消息,就会清除NAT映射,强行掐端长连接

IM中读扩散和写扩散的优缺点

读扩散

- 读扩散,以会话为单位,消息只存一份,群和会话作为收件箱,群收件箱很多

- 节约存储空间

- 但是每个群和会话都需要单独的序列号

- 用户需要储存对话列表,根据对话id拉取消息

- 如果是feed流面临合并麻烦的问题

写扩散

- 写扩散,以个人为单位发号,消息发给每个人的收件箱,

- feed流简单,直接拉展示

- 储存空间浪费,以个人作为维度发号

- 实时性很好,但是容易出现'写风暴'的现象

只下发id的缺点是什么

- 多次冗余的请求,浪费带宽,从两次变为了3次

- 延时增加,在聊天频率很高的情况下,本来只需要下发消息体一次,现在变为下发id,上行请求,下行body,特别是在群聊情况下容易混乱,一次请求没有结束,第二个又来了

- 增大了内存的消耗,必须引入缓存的机制(因为异步化)

- 如果是http请求的话可能出现http的body过大,导致响应时间更加长的情况(应该通过http的压缩)

只下发id的优点是什么,为什么不直接下发消息体

- 有序性的核心保证,拉取返回都是按顺序返回(因为有可能推送顺序问题,丢包的问题)

- 一定程度上保证了必达性,因为即使中间缺失也可以拿到完整正确的

- 一定程度上减轻了写风暴(即群聊的消息大量下发)的压力,减轻IM系统的压力

- 实现异步化拉取,上线拉和在线推的逻辑复用

- 将http和im模块独立,使得IM长连接系统压力减少

- 不需要ack了,pull成为ack,批量下行可以进行压缩,减少流量损耗

如何实现id和消息体两者相结合

双链机制

- 可以改进成为推送body,携带上一条的msg_id,客户端判断上一条是否是,如果是,那么接受这条,更新最新的msg_id,如果不是,那么上行拉取请求,从自己的的msg_id开始拉取,这样可以网络ok直接下发body,减少交互流程,网络不ok恢复成原来的,也可以保证通过双链保证有序性和必达性,这个方法有缺陷,需要查询上一条消息的msg_id,但是在并发写的情况下会出现读到的不一定是最新数据的读写一致性问题

微信机制

推送模型

- 下发ID和下发data两种模式相结合的形式

- 下发模式分为notify和data两种模式,data为数据体模式,notify为下行ID的形势

- data模式明显比notify模式快,但是可能出现消息丢失的现象(除非使用双链,但是双链重试使得效率降低),因此微信采取的data模式时候是在服务端转换的(接入层更改),这部分意味着由服务器保存一份用户接受到了的最新id,然后通过这个id查询你需要的消息体,打包下发

- Data的状态需由客户端触发形成,触发的时机为客户端主动上服务器来做过一次消息收取的请求。由于在Data状态下需由服务器的ConnectSvr主动去ReceiveSvr获取增量消息,服务器必须知道客户端此时的sequence才能做到通过sequence的比较增量下发消息。所以在进入NotifyData状态前,需等待客户端主动做一次消息收取的请求将此时客户端的sequence保存在ConnectSvr中。

- 在Data状态下,客户端必须对服务器下发的每一个Data进行Ack,并且服务器在下发了Data未收到Ack的这段时间内需关闭Data状态(即在图2的2.7和2.8步骤之间不能再做NotifyData下发)

- 直接推送更加快,但是可能出现乱序和丢失的问题,因此需要严格控制下发body的触发条件

如何实现多端接受消息

- 当自己下发消息的时候,将消息的id和to_uid下发,其他端就通过id和to_uid拉取自己的消息体(to_uid是必须的,因为通过to_uid分表),如果是helper类型的只需要下发groupid和msgid

当网络频繁断线(坐地铁怎么处理)

- 断开后不立刻删除状态消息,标记状态为断线,启动超时删除,短时间重连这更新为新连接

如何解决大量定时器占用大量内存资源造成消息卡顿问题

- 传统的计时器使用二叉堆实现,存取的复杂度是log(n),可以考虑使用时间轮实现,计时系统

这个项目的指标

- 日活10W,每个人平均2s就会有一个上行发消息(发消息,拉取的请求,心跳保活的请求综合),日活10W用户每秒约5000请求,峰值月为3倍,QPS大约在15000左右

- 发送的R99大约在100ms(通过connect层的rpc和route层的rpc,session的rpc共同作用,包括逻辑处理和加解密,20ms消息队列延迟),接受到的延迟大约为200ms(测试方法为自己想自己发送请求,两者的时间戳相减,再减去服务器携带的时间戳),时间主要用于消息在消息队列中的延迟(20ms),核心逻辑处理(10ms(mysql插入(1ms))),50ms的双向延迟

- 单机最大并发数大约在5w左右

最大连接数 = (内存大小/单个连接占用内存) * 系统负载因子,如果不够会触发k8s的扩容机制

项目的性能瓶颈在哪里

- 微服务的层层调用(约60ms的延迟)

- 消息在消息队列中的延迟(两个共约40ms延迟)

- mysql的插入,核心层面的逻辑处理(10ms左右)

高并发下可能的问题

- mysql 写的 QPS 大约在几千到上万之间, 如果出现大量的单点的消息发送的情况下, 可能会出现 mq 的消息堆积, 实时性变差

- 一旦mysql 扛不住挂了, 非常容易引起雪崩效应(重试接着失败导致整体服务呈现不可用)

- 继续分表, 以及横向扩容 mysql 是一个思路, 还有个思路是冷热分离, 中间加一层 mongodb, mongodb 存储7天的数据, 异步同步到 mysql, mongodb 能扛住非常大的写压力, 或者考虑底层存储使用 leveldb 这种, 但是这样的话列表的list 也需要使用 leveldb 存储(leveldb 不支持直接的范围查询)

如何实现消息的撤回和审核

- 下发一条新消息,这条消息指向需要撤回的消息,前端收到之后自动撤回消息(通常使用这种)

- 快速,不需要修改消息的原有状态(这部分需要操作缓存和刷盘)

- 不需要更改现有的逻辑代码,代码入侵程度小,实现简单,逻辑复用(只需要发送消息)

- 需要消耗额外的空间去存储一条消息(磁盘是不值钱的,这点损耗可以接受,而且还能记录撤回时间等有用信息)

- 消息本体没有改变,如果是通过接口api请求依旧可以看到消息体

- 这种底层使用leveldb是最好的,这样可以直接set原来的key然后下发消息

- 删除缓存,修改数据库中消息的状态,下发websocket通知在线用户,离线用户拉到的就是已经修改状态了的

- 不需要消耗额外空间储存

- 消息本体改变,可以直接进行过滤,返回的消息内容不可见

- 慢,需要删除消息缓存和修改数据库(通常撤回的消息都是热点消息,因此比较慢),大新系统中不推荐

如何实现消息的已读未读

- 使用一张表每条消息插入一行,然后ack的消息修改对应消息的状态,每个line记录unreadid和readid,messageid(感觉飞书使用的是这种),客户端拉取消息后在拉取消息对应的已读未读状态,需要额外拉取

- 浪费空间,每条消息都对应一行

- 修改方便,可以实现每条消息的每个人识别已读未读,不会出现后面进群的人自动已读前面的消息的情况

- 修改速度慢,如果一个人连续读了100条消息,需要修改这100条的状态,在大群中更加明显

- 因为是另一张表,堆原有业务入侵小

- 需要额外拉取状态

- 群人数没影响

- 使用一条新消息,状态修改,其他不变,指向原消息,这样拉取到这条的时候直接替换原来的消息

- 可以和撤回消息的通道复用,更加简洁

- 极度浪费储存,一个ack对应一条消息(当然可以多个ack对应一个消息但是依旧非常浪费),这里如果底层存储使用的是leveldb,完全可以等到merge时候合并,参考 LevelDB底层

- 不需要额外拉取

- 下发已读的通知,也不需要上线拉取

- 每一条都需要更改一次,和上面一样的问题

- 记录用户的最大ack值,客户端拉取群所有人的最大ack,比较这个group的msgid和ack比较,

- 只能用于group维度发号的情况,不能用于个人收件箱的情况,个人的msgid不是一样的,无法使用,使得使用的范围小

- 当群里人很多的时候,计算和拉取都很麻烦

- 直接在message字段存储加入is_read字段

- 只能用与私聊,群聊人员变动无法使用

- 设计和使用简单

- 如果是最后设计了来说

- 如果是个人会话,个人收件箱+is_read/新消息

- 群会话 群收件箱+记录最大ack值

个人维度和会话维度发号优缺点

个人维度

- 可以实现个人的收件箱,

- 消息储存的冗余,每个群个人的收件箱都需要有一份msg_id,对于大新群聊来说每条消息大量插入每个人的收件箱使得其非常慢(每次插入是log(n))

- 无视会话的数量,每次拉取消息只需要拉取自己的收件箱,实现无感知

- 统计维度消息数量简单,适合用于私聊,不适合用于群聊,私聊不用生成group,可以直接发送,更加简单

- 必须设计新的发号器,用这个做群聊出现风暴的问题

- 拉取历史记录麻烦,自己发的消息查出来需要应用手动合并

会话维度

- 已读未读的实现更加简单,拉取历史消息更加简单(不需要),传播速度更加快,因为只需要插入一次zset

- 每个群维护一个发号器,每个人拉取未读消息麻烦,未读消息数量统计麻烦,适合用于群聊,不适合用于私聊,因为每个人都需要维护一个group,数量变得非常大

- 可以使用mysql id作为发号,需要维护每个人对应每个group的未读消息

- 其实可以结合使用,个人私聊使用个人收件箱,群聊使用群收件箱

微信方案

消息模型

- ack的在进入界面,退出界面,在界面停留几秒都会发送ack

私聊

- 私聊以个人维度发号,和tira中的私聊设计类似

- 这样可以很方便做管理(只需要拉一条时间线上的消息)

- 微信这部分的私聊消息很可能压根没有做MQ,估计为了保证不会丢消息,一定是写消息成功落库之后才会返回前端成功.收件箱为了持久化存储,使用的不是redis这种内存数据库,估计是类似leveldb这种

群聊

实际上微信基本上都是用户一个inbox,使得不支持大群,而且不好做已读未读

- 群聊使用群聊收件箱的机制,和help的机制一样,维护群聊收件箱

- 群聊维度使用群维度发号,以群id维度发号,类似读扩散

helper中为什么需要两个hash而不是一个

- 一个用于记录ack(做已读未读),一个用于记录未读群聊,如果使用一个那么第二个hash就不能删除项,每次拉取都需要遍历hash中所有的session(即群聊),非常低效很慢,分开可以优化未读信息的通知

如何实现容灾

- redis使用集群模式加主从架构加哨兵监控,崩溃时候可以自动切换成为slave的redis成为master

- mysql使用一主一从的双机主备高可用,如果master挂了slave自动成为masterMysql底层原理 > keepalive

- 微服务使用k8s统一管理,如果出现负载过大,会生成新的docker微服务

- 使用mira和普罗米修斯和grafana监控状态,警告接入飞书通知,通过grafana查看请求QPS(记录消息数,成功数,rpc调用平均延时)

- 如果逻辑层连接数据库一直失败(网络波动),尝试次数过多后会将数据写入文件并发出预警(这部分可以变成使用消息队列,只有落库成功才返回处理成功,否则让数据库进行重试)

- 限流器,避免出现服务的雪崩效应(A崩了,B承受A+B的请求也崩了),尝试失败后前端直接显示红点或者进行重试

- redis崩了从mysql拿数据的时候异步缓存到redis(这里可能出现刚上线请求压力大的问题,容易产生缓存雪崩,可以上限流或者提前缓存),这里的缓存是缓存收件箱

长连接维护占用大量的资源,如何优化

- k8s水平扩展增加实例

- 拆分im和http成为两个部分,减低im部分的压力, 这也是下面 helper 的设计原因, 通过拆封 http 服务和 IM 服务有效降低服务负载, 并且解耦 长链接和 http 链接的部分, 有效避免了因为 长链接服务 down 导致所有服务不可用的问题

哪部分架构自己设计的,开发时间人员

- 路由层的具体逻辑自己设计的,参考了openim,goim等

- gennerator自己实现的,设计参考了美团leaf分布式id生成器

- 微服务的划分是参考了之前的im项目

- 一共3+1个人,花了两个月多一点

如何实现优雅退出/升级

- 微服务框架中自己携带有退出函数,接受退出信号

- 如果是 http 服务, 直接通过服务注册平台下线实例, 然后上线新实例解决

- 如果是长连接的部分

- 当出现退出信号的时候,查找所有的长连接,下发特定的通知然后断开长连接,清理长连接部分,客户端收到这个不会提示

- 高级一点的方式是通过 fork + exec + 信号的技术, 通过发送信号升级, 通过 fork+ exec新的程序实现升级, 老的直接 exit (利用的是 fork之后可以基层 socket的特性), 但是普遍比较复杂 + 如果是 k8s + pod 的形式难以执行 ,进程级别倒是适用

- k8s创建新的pod之后发送信号给旧的pod,旧的pod,会有一个最大退出时间的限制(超过直接kill),同理知道所有的pod全部被替换

如果出现错误包格式如何处理

- 直接掐断这个tcp连接,关闭改tcp连接

如何提高系统的高并发及可用性

- 可用性高并发核心还是分布式架构 > 保证高可用性的方法

- 水平扩展微服务提高承载能力

- 使用消息队列实现异步和解耦削峰

- 服务降级的兜底策略

- 数据库的容灾备份

产品迭代过程

- 第一版使用sync_pull打包成一个结构体一起发送

- 自己指定协议的包长度有限制,一次性推送未必足够长,因此采用FIN和LV方法

- 使用redis作为List缓冲,如果一次性发造成失去redis缓冲的作用

- 因为edge_connect同时服务多个用户,太长的包容易让connect长期为这个连接工作

- pull代码逻辑复用

- 因为改成一个一个发送,需要fin告诉客户端发送结束,也需要lv让服务端删除缓存,没有fin包,客户端无法知道什么时候发送结束,无法合适的时机发出lv

- 第一版使用uid作为streamID

- 开始没问题,后来出现多个设备登陆问题出现二元组相同的情况,不支持多端,因此使用雪花ID生成唯一ID或者号段ID,保证连接唯一性

tira-room

流程

- 客户端进入房间之前首先通过https发送请求,携带uid和roomid,后端处理之后返回token(这里也可能是sessionid)

- 客户端和edge建立tcp连接,发送hello包,使用公钥加密(token,cliran),route解密之后下行serran,返回,并且下行event到edge传递private_key以及uid,roomid

- edge判断是否是本地没有订阅的room,如果是就订阅room

- 上行消息发送的时候在edge进行解密,塞到c2r的chan之后立即返回达到异步处理

- c2r只负责拿到roomid作为消息的seq,并且把包装好的消息下行到route,route将这个消息发布到redis的channel(这个channel是以room为维度的,每个room都会有自己的channel)

- edge将这个channel下面的所有连接拿出来依次下发

QA

为什么edge保存privatekey

- 这里和私聊不同的地方在于不同人有不同的private_key,这样route发送一条消息就需要加密非常多次,性能上不可接受,因此在edge下发前自行加解密更加快和方便

为什么不是一个room一个privatekey

- 理论上可以,甚至我觉得在这个聊天室场景下更加好,没有用是考虑了和私聊同样的加解密步骤,改动小,以及安全性的考虑(因为room的privatekey是公共的)

- 如果是一个room一个privatekey,在生成room的时候生成放在session中,可以直接在下行的时候在route加密,这样第一更加贴合私聊的下行方案,更重要的是edge可以做到不感知业务,其实更加好

为什么使用订阅者模型而不是list

- 大量消息和大量订阅者,而且可以忍受消息一定程度的丢失,订阅模型更加合适,如果是list,无法实现消费多次多个edge拿消息

- 参考数据库总结 > redis做消息队列的几种方式以及缺点

helper

群聊实现

c2c翻版

- 使用收件箱逻辑,推送到,个人收件箱,但是检测type为group则在其他表查

- 依旧通过写扩散解决问题

help版本

- 业务上回避generator,更加简洁(但是这样导致做冷热分离很麻烦)

- 通过读写结合来实现

具体流程

- 客户端建立长连接之后,通过http发送上行请求,handle层简单判断之后放到service层

- 进入service复杂逻辑

- 幂等性校验

- 落mysql库获取seqID

- 加入redis缓存

- 加入group的zset(用于记录群里面的消息ID)

- 查询群成员

- 给除了自己以外的所有群成员添加收件箱(收件箱为hashmap结构,key为groupID,val为最新的非自己发送的msgID)

- 获取在线人员的名单

- 通知在线(除了自己)的人,通过edge长连接下发消息

- 异步审核和异步下发微信通知

区别

- 从个人收件箱转为群收件箱,减少了消息的冗余,个人的新消息通知使用个人的redis hash,维护客户最新的ack和最新的消息msgid,通过对比两者的值决定自己是否有新的消息,无法维护客户端最近的ack和最新的消息,缺点是取法具体显示多少条消息未读,优点是拉取历史消息更加方便(因为是基于群维度),而且因为只需要插入一次zset传播速度更加快

- 使用mysqlid作为seqid,不需要generator,因为消息以群维度生成和发送,无上面问题

- 将上行消息http化,实现逻辑更加轻量化,读扩散模型,tira为写扩散模型

- 长连接占用大量内存资源,IO密集型,因此将IM和http拆分成两个系统

产品迭代过程

自己发消息的问题

- 一开始使用set作为收件箱,保存未读group,发现自己发的消息出问题

- 如果im下发,那么会出现自己的消息是未读消息

- 如果不下发,因为拿到的msgid不是最新的(没有自己的msgid),无法ack

解决

- 使用hash作为收件箱,自己的消息不写收件箱,始终使用不是自己发的最新的msgid作为收件箱group的值

为什么使用http 服务和 im 服务拆开两个程序

- 业务逻辑角度上看 , http 服务主要在于 CPU 的逻辑运算和外部调用, 是一个cpu 为主的, IM 维护长连接需要的内存很多, 是内存为主的, 如果放在一个服务上面, 对服务的压力很大, 相当于承载了所有的功能, 拆开降低耦合度, 而且 http 部分迭代非常频繁, 长链接部分比较稳定, 为了避免迭代的异常影响也应该拆开

- 安全性上看 , 加密系统是现成的, 可以直接使用 https 的加密, 维护长连接部分不涉及秘密, 不需要进行加密

- 容灾角度上看, 放在一起一旦程序被kill 意味着IM 完全不可用, 拆开的话即使 IM 挂了 发消息拉消息的功能也不受影响,只是损失实时性, 这部分完全可以通过客户端发现 IM 异常之后走定时拉取的兜底逻辑进行止损

等待改进

- 消息可以类似openIM做冷热分离,避免mysql压力太大,消息的分级存储,14天内的消息可以直接存在leveldb中(毕竟消息的写多,读大多数是缓存读),或者mongodb中(IM系统几乎不涉及事物特性)

- 使用消息队列代替chan和redis的list,保证消息的进一步必达性,如果真的添加消息队列nsq,逻辑层从nsq拿出来后进行处理,拿出就返回ok(因为失败毕竟是少数情况,重新放回不会影响太多的性能,避免大量消息因为没有ack而在等待,最重要的是,需要修改字段标记处理阶段和重试次数),如果处理失败修改继续放入队列延迟重试(这部分可能造成消息的积压),向connect中推送也使用(这个一般不涉及处理连接失败和重试,而且这部分消息丢失的代价较小,因此不一定需要使用消息队列)

- 消息的必达性还是不能真正保证,最好是直接先落库才返回成功

- 没有做已读和未读(可以通过个人收件箱的hash存储自己读到的和最新的来实现)

- 无法确定每个group有多少条未读的消息(可以通过个人收件箱的hash存储自己读到的和最新的来实现)

- 客户端发送消息的顺序可能和服务端处理接收到的顺序不一样,导致接收方乱序(可以通过客户端的client_msg_id递增,服务端保存上一条client_msg_id,如果发现不匹配就返回失败,类似双链的机制,保证消息形成一个链式结构,但是还是无法解决服务端异步发id可能混乱,这里可以考虑将幂等性处理和发消息id放到前面(这两个都不怎么耗时)或者通过滑动窗口的形式,一次性处理多条消息(按照一定顺序),缺点是通讯重试次数太多,性能差)

- 可以改进成为推送body,携带上一条的msg_id,客户端判断上一条是否是,如果是,那么接受这条,更新最新的msg_id,如果不是,那么上行拉取请求,从自己的的msg_id开始拉取,这样可以网络ok直接下发body,减少交互流程,网络不ok恢复成原来的,也可以保证通过双链保证有序性和必达性,如果是直接下发body模式,这个逻辑也可以应用在下行双链保证有序性(每条消息携带上一条消息的id) , 这个的问题是怎么确定上一条 id 是多少 , 除非能保证连续绝对递增

- 没有做限流,太高的qps容易使得系统的消息处理时间大大延长

- 没有做系统的容灾,redis挂了使得未读信息通知消失,mysql挂了会使得消息发送失败当客户端以为成功的事故

- 没有做弱网情况下的优化

- 幂等性应该做双重幂等,redis+数据库private_key设置

- tira-im群聊的扩展性很差,因为按照这个模型,群聊1000个人就要发1000个号,插入1000次zset收件箱,导致写扩散的现象非常明显

- push 实例扩容时候一致性hash 没办法马上让其负载均衡, 很容易出现刚来的负载比较低的问题(因为 tcp长连接没办法直接转移)

参考

- http://www.52im.net/forum.php?mod=viewthread&tid=3631&highlight=%CE%A2%D0%C5

- https://juejin.cn/post/7070290856967667742

match

- 陌生人匹配服务

- api微服务先通过个人的信息计算一堆参数,然后通过rpc调用match微服务

- match将这堆参数拼接成string插入redis,通过这堆参数各种各样的计算,得到不同的zset,(key为时间戳),将个人的匹配信息加入redis(key为uid,val为uid)设置超时时间作为结束匹配的标志,

- 每一个zset中都有协程在brpop,拿出来之后使用这个人的uid加锁,标识已经在匹配了,分配唯一match_id

- 继续从队列中拿出用户进行匹配,成功匹配通过长连接下发匹配成功的通知

- 这部分非常复杂,只是简单的思路,具体的后面有空再看吧

gennerator

- 分布式ID生成器

- 通过提前拿号和异步检查分配的办法(每次分配之后查一下是否已经分配超过60%,如果超过了,异步开协程那下一个号段)解决mysql速度不够快的问题

- 号码一定递增,但是不一定连续(因为如果宕机,下次回复只能拿到下一个号段,无法确定上一个号段是否发完了)

- 通过负载均衡,使得同一个号码的拿取服务全都打到同一台机器上,避免了出现因为多个号段同时发号导致号码不递增的问题

- 通过一致性hash实现自动容灾和恢复,类似[[redis实现#一致性hash算法(一致性哈希)]]

- 构建主机数组,使用二分搜索搜索key对应处理的主机端口ip

- 当处理的机器更改时候(添加或者删除),向旧的机器发送删除内存对应号段的通知(这里需要确保加入的都是新启动的,内存没有号段的,这个特性依赖微服务框架的隔离机制),这里的删除不是新的机器删除,而是框架中自带的client调用端发rpc请求删除

- rpc请求拿到所有的发号机器的ip和port,一致性hash算出自己访问哪一台机器

- 检查是否和上一次请求的机器相同,如果不相同,向上一台机器发送删除的通知,如果因为下线,连接失败没关系,如果在线,会删除缓存中的号段

- 向请求的机器发送rpc请求申请发号

- hash环的计算全部都在client中,和服务端无关

- 使用的是类似锁的机制(实际上使用的是sync.map)

//从本地缓冲池获取已经设置的Segment Getter,并且调用获取设置的segment执行

//检查是否能够生产ids, 无法生成则回源获取segment

if cachedSegmentFn, ok := pool.segments.Load(key); ok {

segment := (cachedSegmentFn.(SegmentIDCacheGetter))()

if segment == nil {

logger.Errorf("Generator segment not found:%s[3]", key)

return nil

}

var isAccord bool

nextIDs, isAccord = nextIDFn(segment, 0)

//满足条件1

if isAccord {

return nextIDs

}

applyed = int64(len(nextIDs))

//重置key对应的segment fn, 否则sync.Map的LoadOrStore无法正确执行

pool.segments.Delete(key)

}

//multi-goroutine情况下并发获取的都是waitGetter,仅当唯一获取了segmentFn的Goroutine完成初始化后返回

var startTime = time.Now()

var initSegment *entity.NamespaceSegment

var wg sync.WaitGroup

wg.Add(1)

waitGetter := func() *entity.NamespaceSegment {

wg.Wait()

return initSegment

}

//only one goroutine to call fn()

//大量协程尝试写入这个sync.map

segmentGetter, loaded := pool.segments.LoadOrStore(key, SegmentIDCacheGetter(waitGetter))

if loaded {

//因为多个协程竞争导致,大部分协程到这个地方,然后进行等待,**注意,这里等待的并不是自己的wg,因为自己的wg压根没有成功存进去,等待的是成功存进去的wg,即拿到执行权限的wg**

//block here wait first getter done

segment := (segmentGetter.(SegmentIDCacheGetter))()

if segment == nil {

return nil

}

nNextIDs, isAccord := nextIDFn(segment, applyed)

if !isAccord {

return nil

}

return append(nextIDs, nNextIDs...)

}

//成功写入的协程到这部分

//Store成功,初始化Request

initSegment = segmentFn()

wrapGetter := func() *entity.NamespaceSegment {

return initSegment

}

pool.segments.Store(key, SegmentIDCacheGetter(wrapGetter))

//完成wg,通知其他协程起来

wg.Done()

////////////////////////////////////////////////

// 这部分是nextIDFn的内容,底层还是使用atomic实现的

func(segment *entity.NamespaceSegment, applyedN int64) ([]int64, bool) {

var apply = n - applyedN

//有效的ID列表, 超出保留的ID列表

var validIDs []int64

var counter *int64

if iCounter, ok := globalCounter.Load(key); !ok {

return nil, false

} else {

counter = iCounter.(*int64)

}

// 注意这里是先进行原子递增,在进行拿出号码,这样可以实现多个协程一起拿的操作

nextID := atomic.AddInt64(counter, apply)

if nextID <= segment.MaxID {

for s := nextID - apply + 1; s <= nextID; s++ {

validIDs = append(validIDs, s)

}

return validIDs, true

} else {

for s := nextID - apply + 1; s <= segment.MaxID; s++ {

validIDs = append(validIDs, s)

}

return validIDs, false

}

负载均衡

类型

- 层次指的是对应网络模型的哪个层次

四层负载均衡

- 通过IP+PORT进行负载均衡,在TCP网络层面进行划分

七层负载均衡(nginx)

- 在四层的基础上(没有四层就没七层)

- 将请求通过应用层协议进行区分和负载均衡

[!question] 垃圾python玛德天天不会对下兼容,天天他妈的报错,和nodejs一个吊样 果然不是用来写大型项目和后端的,兼容性就玩崩

常见错误

ImportError: cannot import name 'html5lib' from 'pip._vendor'

- pip版本太低

curl -sS https://bootstrap.pypa.io/get-pip.py | sudo python3.10

curl -sS https://bootstrap.pypa.iomirrors.aliyun.com/pypi/simple/)

/get-pip.py | sudo python3

设置镜像源

临时

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple <需要安装的包>

永久

pip install pip -U

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

[!NOTE] 清华源403 还是得用阿里的源 Simple Index

虚拟环境创建

创建

pip3 install virtualenv(默认py只带不用安装)mkdir venv;cd venv;python3 -m venv <虚拟环境的路径,可以是.>,在目录下会创建venv文件夹,是虚拟环境的核心文件source venv/bin/activate- 使用

pip3 install -r requirements.txt安装依赖

退出

deactivate

目录关系

- 文件夹需要存在

__init__.py才会被认为是一个包,这种情况下才能被导入,包不能直接运行但是可以通过python3 -m <包名>.<文件名(不带后缀>运行

setup.py

- 是用来构建一个包的方便其他人pip安装

[!tip] 参考 python之setup.py快速了解和使用 - popsicle - 博客园 (cnblogs.com)

requirements.txt生成

pip freeze > requirements.txt不推荐,会生成一大堆乱七八糟的包依赖信息- 推荐方式

pip install pipreqs

pipreqs ./ --encoding=utf8 --force

pip安装

- 运行

$ curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py # 下载安装脚本

$ sudo python get-pip.py # 运行安装脚本

pip镜像加速

- 一次性

pip3 install numpy -i https://pypi.tuna.tsinghua.edu.cn/simple - 永久设置

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple/

pip config set install.trusted-host pypi.tuna.tsinghua.edu.cn

[!tip] 参考 pip 使用国内镜像源

各种进制的表示

0B00001101 0xff 076

clangd消除警告的方法

- 核心参考官方文档

- 编写项目的

.clangd文件,然后添加需要抑制的内容,这个内容可以根据提示获取

Diagnostics:

Suppress: -Wc++17-extensions

- 头文件检查的,在

.clang-tidy添加

Checks: -misc-definitions-in-headersChecks: -misc-definitions-in-headers

clangd找不到头文件方法

cmake -DCMAKE_EXPORT_COMPILE_COMMANDS=1

- 会生成

compile_commands.json - clangd索引会生成

.cache文件夹

clang-format格式化方法

- 傻逼clangd-format必须制定

-style=file才会根据.clang-format格式化,否则直接 - vim文件可以参考

https://raw.githubusercontent.com/llvm-mirror/clang/master/tools/clang-format/clang-format.py

" BEGIN CLANG-FORMAT CONFIG

" imap <C-K> <c-o> :pyf /home/zhuling/code_standards/format/clang-format.py<cr>

nmap <leader><leader>f :pyf /home/zhuling/code_standards/format/clang-format.py<cr>

function! Formatonsave()

let g:clang_format_path = "/home/zhuling/code_standards/format/clang-format"

let l:formatdiff = 1 " 保存文件时针对改动的代码进行格式化,历史代码不动

"let l:lines="all" "如果保存文件时也希望对历史代码做格式化,可取消该行的注释

pyf /home/zhuling/code_standards/format/clang-format.py

endfunction

autocmd BufWritePre *.h,*.cc,*.cpp call Formatonsave()

" END CLANG-FORMAT CONFIG

compile_commands.json生成方法

- cmake,

apt install cmake

cmake -DCMAKE_EXPORT_COMPILE_COMMANDS=1

- bear,

apt install bear

如何编译的在前面加上

bear --,类似bear -- make,bear make

- clang,

apt install clang

clang -MJ compile_commands.json source.cpp

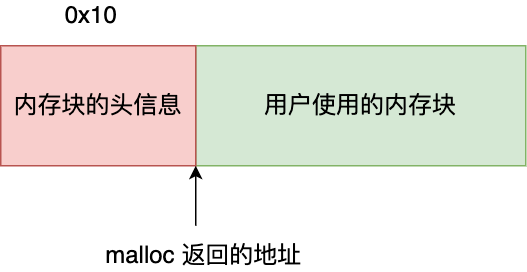

malloc

C++多态的多种实现

- 重载。函数重载和运算符重载,编译期。

- 虚函数。子类的多态性,运行期。 在继承关系中,对于父类的方法我们也同样使用。但是正常来说,我们希望方法的行为取决于调用方法的对象,而不是指针或引用指向的对象有关。

- 模板,类模板,函数模板。编译期

智能指针

weak_ptr

- weak_ptr<T> 模板类中没有重载 * 和 -> 运算符,这也就意味着,weak_ptr 类型指针只能访问所指的堆内存,而无法修改它。

- weak_ptr主要针对shared_ptr的空悬指针和循环引用问题

- 空悬指针问题:有两个指针p1和p2,指向堆上的同一个对象Object,p1和p2位于不同的线程中。假设线程A通过p1指针将对象销毁了(尽管把p1置为了NULL),那p2就成了空悬指针。

- weak_ptr不控制对象的生命期,但是它知道对象是否还活着。如果对象还活着,那么它可以提升为有效的shared_ptr(提升操作通过lock()函数获取所管理对象的强引用指针);如果对象已经死了,提升会失败,返回一个空的shared_ptr

- 当 weak_ptr 类型指针的指向和某一 shared_ptr 指针相同时,weak_ptr 指针并不会使所指堆内存的引用计数加 1;同样,当 weak_ptr 指针被释放时,之前所指堆内存的引用计数也不会因此而减 1。也就是说,weak_ptr 类型指针并不会影响所指堆内存空间的引用计数

static作用

- 如果用 static 关键字修饰的话,该变量便会存 放在静态数据区,其生命周期会一直延续到整个程序执行结束

- 用 static 对全局变量进行修饰改变了其 作用域范围,由原来的整个工程可⻅变成了本文件可⻅

- 用 static 修饰函数,情况和修饰全局变量类似,也是改变了函数的作用 域

- 对类中的某个函数用 static 修饰,则表示该函数属于一个类而 不是属于此类的任何特定对象;如果对类中的某个变量进行 static 修饰,则表示该变量以及所 有的对象所有,存储空间中只存在一个副本,可以通过;类和对象去调用。

强制转换

dynamic_cast

- 用于指针或者引用父类转子类,如果转失败返回NULL

static_cast

- 和C的强制转换差不多

const_cast

- 用于去除和加上const

reinterpret_cast

- 完成任意指针类型向任意指针类型的转换

others

- string的substring函数第二个参数是len长度而不是pos

push_back和emplace_back区别

- push_back 接受一个对象,将其拷贝(或移动)到容器中,而 emplace_back 接受一组参数,直接在容器中构造对象。

- push_back 调用对象的拷贝构造函数(或移动构造函数),将对象拷贝(或移动)到容器中,而 emplace_back 调用对象的构造函数,在容器中直接构造对象。

- 使用 emplace_back 比 push_back 更高效,因为它避免了对象的拷贝(或移动)操作,直接在容器中构造对象。此外,emplace_back 还可以支持可变参数,可以方便地构造带有多个参数的对象。

- emplace_back 的参数必须和对象的构造函数参数匹配,否则会编译错误。而 push_back 接受的是一个对象,因此可以隐式转换类型

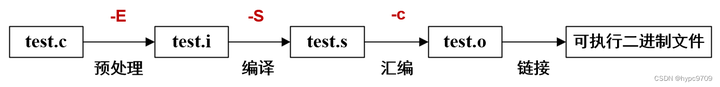

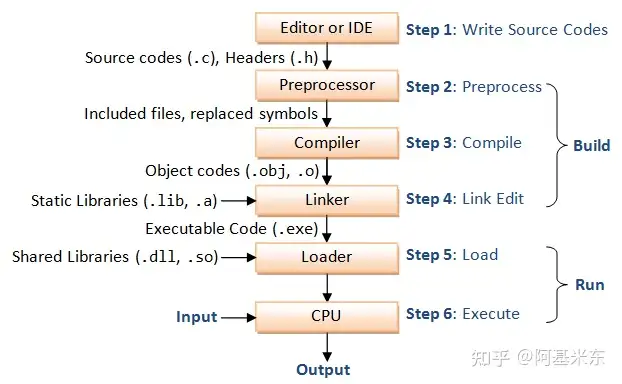

编译顺序

预处理

- 将所有一起编译的

.c文件合并 - 将宏展开计算,将注释以及删除无用字符

- 将头文件内容插入到源文件(因为#include也是宏,本质还是宏展开),头文件路径的添加可以通过

-I - 通过这个步骤的带一个文件包含了精简化后的所有的源代码(当然还是不包括库的)

编译

- 这一步将上一步得到的源代码进行编译成为汇编代码

- 这一步只会检查代码的正确性,不会检测所需要的函数是否有实现,如果函数没有定义,但是引用了会在这里报错,但是定义了,使用了,没有实现,这里还不会报错

汇编

- 汇编器会将汇编代码转换成二进制指令,同时生成与指令相关的符号表和重定位表

链接

- 这一步非常重要,链接器会解析所有目标文件中的符号,包括函数名、变量名等,并为每个符号分配一个唯一的地址。由于不同目标文件中的符号地址可能会相互引用,链接器需要对这些符号进行重定位,即将符号的地址修改为正确的地址。链接器还会将程序所依赖的库文件链接到可执行文件中,以便程序在运行时可以调用库函数。

- 定义了使用了没有实现的函数会在这里被发现,包括引用了外部的

.a静态库但是没有通过-l加入也是在这里发现,一般是白色的undefine的错误,链接器会检查每个跳转的是否ok - 这一步中如果需要加入

.a(linux)或者.lib(win)的路径,可以通过-L,对应-l通常就是静态库的名字

右值引用

类型

- 左值指存储在内存中、有明确存储地址(可取地址)的数据;

- 右值是指可以提供数据值的数据(不可取地址);右值又分为纯右值(prvaule),亡值(xvalue),纯右值指的是类似1,2这种纯数字,这种不能纯数字不能被修改,亡值指的是类似函数返回值,函数参数,临时变量这种临时构建,非引用返回的临时变量、运算表达式产生的临时变量、原始字面量和 lambda 表达式,这部分可以被右值引用修改

- 右值引用可以延长生命周期如下面,可以减少临时对象的构建

int&& value = 520;

class Test{

public:

Test(){

cout << "construct: my name is jerry" << endl;

}

Test(const Test& a){

cout << "copy construct: my name is tom" << endl;

}

};

Test getObj(){

return Test();

}

int main(){

int a1;

int &&a2 = a1; // error

Test& t = getObj(); // error

Test && t = getObj();

const Test& t = getObj();

return 0;

}

- 可以通过移动构造函数减少不必要的构造

std::move

- 将数据转化为右值,标记对象为临时对象

- 本身上并没有什么效率提升,仅仅只是一个转换为右值的功能,但是因为可以转换为右值,可以调用右值的构造函数,右值的构造又可以避免对象的拷贝(虽然左值也可以实现,但是左值更多是copy而不是move,因此会有const,右值就没有const),具体参考

::运算符

- 表示使用某个命名空间下的操作

- 如果前面没有命名空间表示全局的意思,全局的命名空间

宏中使用do{}while(0)原因

- 使用do{...}while(0)构造后的宏定义不会受到大括号、分号等的影响,总是会按你期望的方式调用运行

如果仅仅使用func1();func2(); 遇到使用if加单行语句就会出问题

构造函数=default的作用

- 用于标记使用默认的构造函数,如果有的构造函数和编译器默认生成的一样,字节使用=default(特别是拷贝构造函数)

C++代码计算运行时间

- 参考示例

int main() {

// "start" and "end"'s type is std::chrono::time_point

time_point<system_clock> start = system_clock::now();

{

std::this_thread::sleep_for(std::chrono::seconds(2));

}

time_point<system_clock> end = system_clock::now();

std::chrono::duration<double> elapsed = end - start;

std::cout << "Elapsed time: " << elapsed.count() << "s";

return 0;

}

奇形怪状的错误

type nofind 错误

- 一定需要考虑是不是头文件重复包含的问题 A头文件和B头文件都include了对方,导致顺序出问题了,可以考虑用extern 声明避免nofound

the vtable symbol may be undefined because the class is missing its key function

- 类中的第一个虚函数没有实现,导致虚函数表没有办法实现

warning:#pragma once in main file

- 不要编译头文件,带着头文件编译就会有这个错误,确保g++的命令接的全是.cpp的文件

multiple definition of

- 核心是因为头文件中包含了实现(理论上应该放到cpp文件中)

- 因为C++编译器是按照 .cpp文件变异成为.o文件,如果多个cpp引用同一个头文件,每个.o文件都有一份实现,最后.o链接的时候就会出问题

- 但是下面几种情况是例外的

- 内联函数的定义

- 因为内联函数直接被替换了, 不会出现函数的概念

- class/struct/union 定义的函数

- 类里面的函数实现如果放在头文件中默认变成内联的,直接替换不会出问题

- const 和 static 变量

- static限制了变量的作用域,该变量仅在引用.h的源文件中有效,也就是说.h被引用了几次这个变量就被定义了几次,且各变量之间互不影响(各变量具有不同的内存地址)。这种方法不适用于定义全局变量,因为它们不是同一个变量。

- const 默认就是static类型的变量

- 内联函数的定义

[!tip] 参考 zhuanlan.zhihu.com/p/577994847 注意头文件规则,避免链接错误:重复定义(multiple defination) - bw_0927 - 博客园 C++ multiple definition 总结 - 简书

socket broken pipe问题

- 对已经关闭的socket 执行二次写的时候会出现, 可以通过

signal(SIGPIPE, SIG_IGN);解决

如何给random函数设置随机的seed

#ifdef __i386

__inline__ uint64_t rdtsc()

{

uint64_t x;

__asm__ volatile ("rdtsc" : "=A" (x));

return x;

}

#elif __amd64

__inline__ uint64_t rdtsc()

{

uint64_t a, d;

__asm__ volatile ("rdtsc" : "=a" (a), "=d" (d));

return (d<<32) | a;

}

#endif

- 使用嵌入式汇编来获取CPU的时间戳计数器(TSC)的值。TSC是一个递增的64位计数器,它记录了从电源启动或者最近一次复位以来的时钟周期数。64位架构中,由于TSC的值超过了32位寄存器的容量,所以需要使用两个32位寄存器来存储TSC的高位和低位,并将它们进行位移和合并操作,最后返回一个完整的64位值

sizeof和strlen区别

- sizeof计算char* 类型时候计算的是指针的长度,而不是字符串长度,strlen则看作是字符串,但是字符串不计算

\0,因为\0被视为字符串结束的位置 - sizeof计算char[]类似的时候计算的是字符串长度,而且包括

\0

C++协程实现

- 底层还是通过linux提供的API makecontext实现的,实现可以参考

multiple definition of问题

- 不要把全局变量以及全局方法的定义放在头文件里!!!!,这样就会出错

- 核心是因为编译器编译分开每一个cpp的时候直接他妈的展开了所有的头文件,放在一起编译就不会有问题

- 但是class的静态函数就没问题

spdlog的问题

显示一大堆nodefine的问题

[!tip] 参考 https://blog.csdn.net/CSSDCC/article/details/121854773 https://fmt.dev/latest/usage.html#usage-with-cmake

- 可以直接在makefile中添加

-lfmt手动链接,makefile

代码规范

核心参考Google C++规范 #代码规范

- 注意头文件和对应的源文件实现要放在同一个文件夹中, 不要用愚蠢的include文件夹

命名

- 枚举enum的命名 应当和常量 或宏 一致: kEnumName 或是 ENUM_NAME.

- 宏的命名不要以下划线开头,因为这是C语言标识符保留的

- 变量使用下划线命名法+小写

- 函数和类使用驼峰法+首字母大写

- 命名空间使用全小写,不要出现下划线

- 类内部属性使用下划线命名法+下划线的后缀

player_pos_

Class

- 类应该public放在前面(因为这是直接暴露给使用者的),private放在后面

- set值方法

set_pos(Pos pos)使用 set+属性名字 小写 - get值方法直接使用

pos()使用小写名字 - 类内部属性使用下划线命名法+下划线的后缀

player_pos_

项目组织规范

- 参考 GitHub - chenxuan520/cppnet: Lightweight C++ network library

- 第三方引用的仓库, 如果是编译类型的, 通过 submodule 添加到 third_party , 然后编译时候一起编译, 如果是二进制类型的, 通过脚本进行下载引入即可, 不要直接放到仓库中

- hpp 和对应的 cpp 放在同一文件夹

- test 文件夹是必要的, 作为单元测试存在

错误标识

- 通过返回RC,然后设置RC到string的转移,大多数使用这种办法

- 麻烦,但是标准程度高

- 返回特定的Err结构体,类值go的error,

- 标准,但是通用型差

- 返回int标识类型,参数中携带std::string& err_msg标识错误信息,微信支付方法

- 通常小于0标识系统错误,大于0标识逻辑错误

有用的宏

[!tip] 这些宏必须经两层包装才能被使用

__LINE__ :当前行数

__func__ :当前函数名

__FILE__ :当前文件名

__COUNTER__ :计数器,会随着调用递增

Lambda 表达式捕获

- 默认是使用

=捕捉所有的值拷贝,使用&捕捉所有的引用拷贝 - 如果使用

[x]默认只捕获这个值拷贝,[&x]默认只捕获这个引用拷贝

内存泄漏检查工具 valgrind

- 安装

apt install valgrind - 使用

valgrind --tool=memcheck --leak-check=full <二进制文件> - 注意 这个和cmake > 内存泄漏检查sanitize 冲突不要一起使用

参考(重要)

- project-setup

- files

- https://blog.csdn.net/weixin_51609435/article/details/126571057

基本容器

vector

- 底层为数组

- 新建时初始化一片空间

- 插入元素引起扩容的时候,gcc会申请2倍的空间,拷贝原有数据

- 释放原来空间

deque

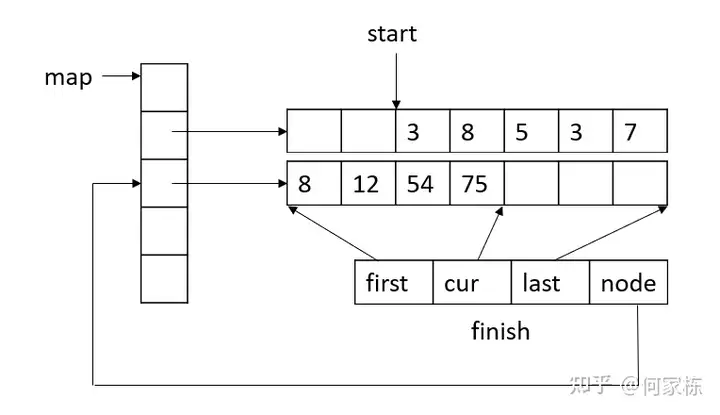

- 底层为map+数组的结构,通过分段存储的结构解决队列进出频繁的问题,本质上还是类似vector的结构

list

- 双向链表

set map

- 底层为红黑树

unordered_set unordered_map

- 底层为hash,使用哈希桶的方法,使用拉链法解决hash冲突

stack queue

- 底层都是deque经过改装适配

priority_queue

- 底层还是vector,然后使用堆排实现

参考

- https://zhuanlan.zhihu.com/p/359878588

架构图

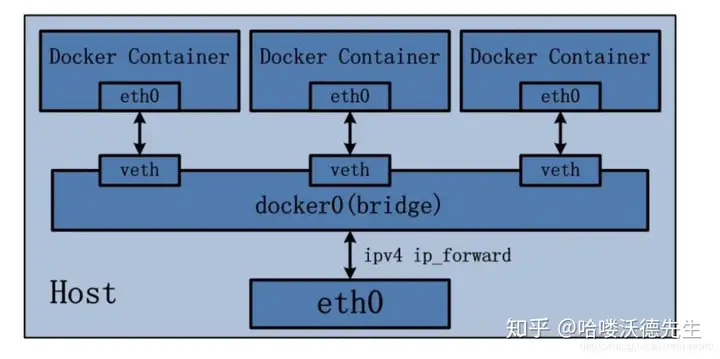

- 连接先通过tcpserver建立连接,使用epoll+多线程的模式

- 读取完整的http报文,出错直接返回请求错误

- 将报文交给deahttp处理,解析http报文,

- 路由通过trie树进行域名的泛匹配

多态的实现

虚函数表

- 虚函数表可以理解为就是一个函数指针数组

functype ptr[] - 虚函数表内部存放的是函数指针,而不是函数地址

- 无论是基类还是子类,(前提有虚函数)都有一个自己的虚函数表,继承时候会直接复制基类的虚函数表

- 重写时候会改写虚函数表里面指针指向的函数地址,达到多态作用

- 子类添加新的虚函数(不是重写,而是新的)会追加在虚函数表最后

- 父类指针拿到子类对象时候,对着表格拿到函数指针,但是实际上拿到的是子类的虚函数表,因此函数指针也是指向子类的,因此实现多态

- 多重继承时候会有多个虚函数表

面向过程区别

- 面向对象是以功能来划分问题,而不是以步骤解决

三大特性

封装

- 类仅仅通过有限的方法暴露必要的操作,也能提高类的易用性

- 增强代码可读性和可维护性

继承

- 代码复用,将这些相同的部分,抽取到父类中,让两个子类继承父类

[!tips] 注意点 继承的时候所有虚函数不要加const, 因为不确定子类重写的时候会不会需要更改, 加上是不合适的

多态

- 提高了代码的可扩展性。

- 只需要根据父类指针调用函数,不用关心子类的具体实现

底层模型

虚拟继承

- 解决菱形继承的问题

- A作为base类会被放在最下面,作为共享部分,然后与base不同部分放在上面

D VTable

+---------------------+

| vbase_offset(32) |

+---------------------+

struct D | offset_to_top(0) |

object +---------------------+

0 - struct B (primary base) | RTTI for D |

0 - vptr_B ----------------------> +---------------------+

8 - int bx | D::f0() |

16 - struct C +---------------------+

16 - vptr_C ------------------+ | vbase_offset(16) |

24 - int cx | +---------------------+

28 - int dx | | offset_to_top(-16) |

32 - struct A (virtual base) | +---------------------+

32 - vptr_A --------------+ | | RTTI for D |

40 - int ax | +---> +---------------------+

sizeof(D): 48 align: 8 | | D::f0() |

| +---------------------+

| | vcall_offset(0) |x--------+

| +---------------------+ |

| | vcall_offset(-32) |o----+ |

| +---------------------+ | |

| | offset_to_top(-32) | | |

| +---------------------+ | |

| | RTTI for D | | |

+--------> +---------------------+ | |

| Thunk D::f0() |o----+ |

+---------------------+ |

| A::bar() |x--------+

+---------------------+

多线程

- 当一个thread对象既没有detach也没有join时候,thread释放(可以是因为栈对象自动释放)后会直接中断程序

- thread提供参数之后不能通过引用传递,但是可以通过指针传递,因为thread构造参数时候直接使用拷贝

- condition_variable的wait调用后,会先释放锁,之后进入等待状态;当其它进程调用通知激活后,会再次加锁

std::unique_lock和std::lock_guard类似,第一个更加灵活,但是性能更加差- 条件变量的用法通常为生产者消费者模型,多个线程用同一个锁+条件变量阻塞

- bind函数可以将函数和参数进行绑定生成一个新的函数对象,这样适配接口就会更加方便

void fun1(int n1, int n2, int n3)

{

cout << n1 << " " << n2 << " " << n3 << endl;

}

struct Foo {

void print_sum(int n1, int n2)

{

std::cout << n1+n2 << '\n';

}

int data = 10;

};

int main()

{

//_1表示这个位置是新的可调用对象的第一个参数的位置

//_2表示这个位置是新的可调用对象的第二个参数的位置

auto f1 = bind(fun1, _2, 22, _1);

f1(44,55);

Foo foo;

auto f = std::bind(&Foo::print_sum, &foo, 95, std::placeholders::_1);// 第二个参数必须是对象作为this指针

f(5); // 100

}

- thread是可以移动的move,但是不能复制copy

条件变量和信号量的区别

- 条件变量支持广播方式唤醒等待者;而信号机制不支持,只能一个一个通知

- 条件变量只能结合互斥量做同步用;信号机制除了做同步,还能用于共享资源并发访问加锁

- 条件变量是无状态的,如果唤醒早于等待,则唤醒会丢失;信号机制是有状态的,可以记录唤醒的次数

多线程demo

class ThreadPool{

private:

std::queue<std::function<void(void)>> task_que_;

std::condition_variable cond_;// 条件变量,通常和锁一起使用

std::mutex que_mut_;// 队列锁

std::vector<std::thread> arr_thread_;

std::atomic<bool> is_close;

std::atomic<int> busy_num_;// 多线程操作,原子变量

public:

ThreadPool(int thread_num){

is_close=false;

for (int i = 0; i < thread_num; i++) {

arr_thread_.emplace_back(std::thread(Consumer,this));// 本身就是右值,可以不适用std::move,如果是左值而且使用emplace_back的话需要std::move避免thread的复制行为

}

}

ThreadPool():ThreadPool(5){}

~ThreadPool(){

is_close=true;

cond_.notify_all();

for(auto& thread_now:arr_thread_){

thread_now.join();

}

}

void Add(const std::function<void(void)>& call_back){

std::lock_guard<std::mutex> guard(que_mut_);

task_que_.emplace(call_back);

cond_.notify_one();

}

private:

static void Consumer(ThreadPool* pool){

if (pool==nullptr) {

return;

}

auto& cond=pool->cond_;

auto& mut=pool->que_mut_;

std::function<void(void)> task{nullptr};

while (1) {

{// 这个作用域结束que_mut_自动释放,为了避免锁的占用

std::unique_lock<std::mutex> unique(pool->que_mut_);

cond.wait(unique,[&]()->bool{return !pool->task_que_.empty()||pool->is_close;});// wait函数首先通过第一个参数拿到锁的控制权,然后不会加锁或者解锁,会等待条件变量的到来,条件变量到来后尝试加锁(多个线程最后只有一个能拿到锁),拿到之后判断第二个参数是否为true,如果为true就继续执行,否则就解开锁继续等待

if (pool->is_close) {

return;

}

task=pool->task_que_.front();

pool->task_que_.pop();

}

pool->busy_num_++;

if (task!=nullptr) {

task();

}

pool->busy_num_--;

}

}

};

void PrintFunc(int print_num){

std::cout<<"run:"<<print_num<<std::endl;

}

int main()

{

ThreadPool pool;

for (int i = 0; i < 20; i++) {

pool.Add(std::bind(PrintFunc,i));// std::bind的作用是生成一个新的函数对象,这个对象可以直接提供参数,达到参数简化的目的

}

sleep(2);

return 0;

}

参考

- 深度探索C++对象模型

Git 其他类型操作

分支重命名

本地

git branch -m <old_branch_name> <new_branch_name>

远程

git push origin <new_branch_name> //新建分支

git push origin -d -f <old_branch_name> //删除旧的分支

回滚

git reset --hard(强制) dhcsdvbhfsjb

git reset dhcsdvbhfsjb

Tag

git tag v1.0.1 #为当前打tag

git push tags #推送tag

git tag #查看tag信息

- 删除tag

# 当前

git tag -d <tag_name>

# 远程

git push origin --delete <tag_name>

pull警告

git config pull.rebase false

git merge

merge 回退

git reset --merge

git merge --abort

merge前检查冲突

git merge --no-commit

revert和reset区别

-

revert 生成一次操作相反的commit, 达到回滚的目的

-

reset直接向前移动指针ref

cherry-pick

-

作用: 将分支的某一次提交应用到别的分支上

-

用法

git checkout branch # 切换向改变的分支

git cherry-pick <commitHash> # 提交的hash

or

git cherry-pick <branch>#默认最近的提交

git cherry-pick <HashA> <HashB> # 一次添加多个提交

git cherry-pick <HashA..<HashB> # 一次添加一系列提交

git stash

- 作用

用于临时保存目前的状态,紧急切换分支

- 使用

git stash #保存

git stash save "test-cmd-stash" # 添加stash信息

git stash list # 列出

git stash apply # 应用stash

git stash apply stash@{2} # 应用stash

git排序文件大小

git rev-list --objects --all | git cat-file --batch-check='%(objecttype) %(objectname) %(objectsize) %(rest)' | sed -n 's/^blob //p' | sort --numeric-sort --key=2 | cut -c 1-12,41- | $(command -v gnumfmt || echo numfmt) --field=2 --to=iec-i --suffix=B --padding=7 --round=nearest

删除git已经跟踪文件

删除

git filter-branch --force --index-filter 'git rm -r --cached --ignore-unmatch path-to-your-remove-file' --prune-empty --tag-name-filter cat -- --all

推送

git push origin master --force --all

排序

git rev-list --objects --all | grep "$(git verify-pack -v .git/objects/pack/*.idx | sort -k 3 -n | tail -5 | awk '{print$1}')"

简单删除

-

git rm --cached readme1.txt 删除跟踪,并保留在本地。

-

git rm --f readme1.txt 删除跟踪,并且删除本地文件。

-

不会删除以前的提交记录

Checkout检出文件

- git checkout (commit_id 为空则默认上一次) -- (需要签出文件名)

二分法查错

- 选定查找范围

git bisect start [终点] [起点]

- 判定该提交为好/坏

git bisect good/bad

gc

- 打包一些老的提交以压缩空间

git gc

[!important] 运行这个命令之后默认只会gc 2个星期前的object,而且danging悬空的对象因为有reflog 导致无法被直接删除,如果需要删除悬空对象,需要运行

git gc --prune=0这个命令的意思是gc从现在开始的对象,以及最开始需要运行git reflog expire --expire-unreachable=0 --all这个命令的意思是立刻清空reflog里的所有从当前head不可达对象(unreachable)的引用(reflog entries)。使得gc可以正确运行

fsck

- 运行

git fsck --lost-found查找所有的悬空对象

cat-file

- 查看hash对应obj内容

git cat-file -p 1234

git cat-file -t 1234

删除本地远程分支

git pull --prune

检查是否冲突

git merge --no-commit --no-ff

# 取消

git merge --abort

Git reflog

- 记录指针每一次发生改变的记录,用于找回分支以及reset hard

Git commit --amend

-

后面不需要添加任何参数

-

修改上一次提交的内容(用于这次修改想合并到上一个修改),不能用于已经提交远程的修改

Squash

git merge --squash, 合并,但只保存一次提交记录

修改默认远程分支

- git branch --set-upstream-to=origin/master master

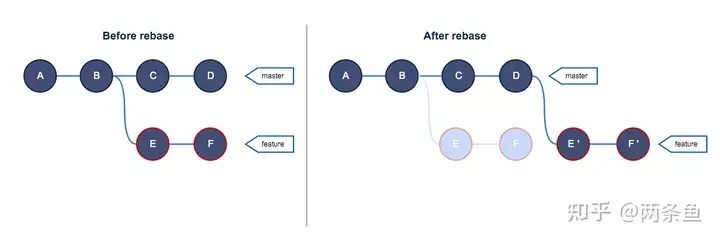

Rebase

- 在feature中

git rebase master,实际上是直接修改了拼接上的位置 - 通过

git rebase --abort停止正在进行中的 rebase

操作

解决合并冲突(尽量少用)

# demo

git checkout feat/some-thing

git rebase master

# resolving git conflicts.....

git checkout master

git merge feat/some-thing

- 切换分支

- rebase master,如上图,将feat分支的base更改为当前的master(实质上是将自己额外的提交拿出来放到当前master的头部),此时新添加的commit会相应的进行合并并生成新的提交记录(和原来的hash不一样,不是同一个提交)

优点

- 操作简单,方便解决冲突

缺点

- 多人使用同一分支会出现灾难

- test环境依旧无法使用,只适用于正式环境

简化提交记录

- !!一旦推送远程,禁止rebase!!

- 不推荐使用这个用法,因为很麻烦而且有可能冲突,不如分支合并到master再squash

- 查看自己的日志,找到需要合并到的hash

- 使用

git rebase -i <commit>命令进行交互式 rebase,或者git rebase -i HEAD^n (n为需要更改的提交数量) - 编辑窗口需要更改的版本前改成s

远程和本地代码合并

用于本地有提交,远程也有提交,pull下来时候的merge

pull=fetch+merge,因此运行git fetch- 执行

git rebase,将本地的commit,拿出来放到远程的头部

禁忌(黄金法则)

- 不要在已经推送到远程的提交进行rebase!!,

- 永远不要rebase共享分支,非常容易造成提交丢失

Submodule

[!important] 注意 submodule的路径不要放在ignore里面, 因为是submodule自己管理的

- 子模块,通过

git submodule add <repository-url> <path>添加,添加后会生成.gitmodules文件

[submodule "third_party/googletest"]

path = third_party/googletest

url = https://github.com/google/googletest.git

branch = release

[submodule "third_party/benchmark"]

path = third_party/benchmark

url = https://github.com/google/benchmark

- 通过

git clone --recurse-submodules这个命令递归clone - 已经拉取的仓库通过

git submodule update --init --recursive --depth=1拉取 - 更新版本需要进入文件夹中主动

git pull

创建

- git submodule add <model_url>

git submodule add -b <branch> <remote> <path>不指定分支就不传-b <branch>

拉取

- git clone url --recurse-submodules

删除

- git submodule deinit project-sub

- git rm project-sub

- 参考

出现'you must specify a branch'

- pull的时候加上分支,如

git pull gitee master

git只回退某个文件或者文件夹

-

回退文件:

git checkout HEAD <file>或者git checkout -- <file>,推荐第一种,这里的HEAD可以直接换成commit-id,这样就是回退到某个地方 -

回退文件夹

git checkout <commit_id> -- <folder_path>

git 命令分页问题

-

git config --global pager.branch false -

参考https://blog.csdn.net/albertsh/article/details/114806994

-

全局设置

git config --global core.pager -

单个命令设置

git config --global pager.branch false

git删除tag

git tag -d <tag_name> #本地tag

git push origin -d <tag_name> # 远程tag

git统计个人代码行数

#!/bin/bash

printf "\n1. 项目成员数量:"; git log --pretty='%aN' | sort -u | wc -l

printf "\n\n2. 按用户名统计代码提交次数:\n\n"

printf "%10s %s\n" "次数" "用户名"

git log --pretty='%aN' | sort | uniq -c | sort -k1 -n -r | head -n 5

printf "\n%10s" "合计";

printf "\n%5s" ""; git log --oneline | wc -l

printf "\n3. 按用户名统计代码提交行数:\n\n"

printf "%28s %18s %18s %18s\n" "用户" "总行数" "添加行数" "删除行数"

git log --format='%aN' | sort -u -r | while read name; do printf "%25s" "$name"; \

git log --author="$name" --pretty=tformat: --numstat | \

awk '{ add += $1; subs += $2; loc += $1 - $2 } END { printf "%15s %15s %15s \n", loc, add, subs }' \

-; done

printf "\n"

printf "\n%25s " "总计:"; git log --pretty=tformat: --numstat | \

awk '{ add += $1; subs += $2; loc += $1 - $2 } END { printf "%15s %15s %15s \n", loc, add, subs }'

[!tip] 参考 https://cloud.tencent.com/developer/article/2087250

git/ssh 设置代理

[!tip] 参考 https://ericclose.github.io/git-proxy-config.html 非常详细

http/https

git config http.proxy http://127.0.0.1:7890

git config http.proxy socks5://127.0.0.1:7891

ssh

这部分也可以用作ssh连接的代理 如果ssh push不上去可以试着把 .ssh/config 里面github内容注释掉 可以先用

ssh -T git@github.com检测是否能够连接

- 编辑~/.ssh/config

Host github.com

User git

ProxyCommand nc -X 5 -x 127.0.0.1:7891 %h %p

# `%h` 和 `%p` 将会被自动替换为**目标主机名**和 **SSH 命令指定的端口**

# -X 是指定默认socket5,不指定也可以

- 或者,SSH连接的代理

# 如果代理服务器需要认证,可以使用 nc 的升级版 ncat 指定代理服务器的用户名和密码

ssh -o ProxyCommand="ncat --proxy-type http/socks4/socks5 --proxy proxy.net:port --proxy-auth proxyuser:proxypwd %h %p" user@server.net

[!tip] 出任何问题看参考文章,很详细

git打包代码压缩包

git archive --output=<output-path>.zip HEAD

# or

git archive --output=<output-path>.tar HEAD

git LF的问题

-

参考# window git crlf lf 换行符问题

// 提交时转换为LF,检出时转换为CRLF git config --global core.autocrlf true // 提交时转换为LF,检出时不转换 git config --global core.autocrlf input // 提交检出均不转换 git config --global core.autocrlf false // 拒绝提交包含混合换行符的文件 git config --global core.safecrlf true // 允许提交包含混合换行符的文件 git config --global core.safecrlf false // 提交包含混合换行符的文件时给出警告 git config --global core.safecrlf warn参考

- https://www.cnblogs.com/hushaojun/p/16001784.html

出现refusing to merge unrelated histories

- 两个仓库不同而导致的,需要在后面加上--allow-unrelated-histories进行允许合并,即可解决问题

- 本质上应该并不会出现这个问题(如果是clone的),考录重新clone仓库

出现 error: remote unpack failed: index-pack failed

- 把

.git文件夹删除之后重建就可以了, 参考 git - Github push error: unpack failed: index-pack abnormal exit - Stack Overflow

出现 RPC failed; HTTP 502 curl 22